2025年最新Chatbox使用DeepSeek-R1全指南:本地部署与API接入详解

引言:DeepSeek-R1开创编程新时代

随着人工智能快速发展,开源大型语言模型(Large Language Models,简称LLMs)的性能不断突破,DeepSeek-R1作为国内团队研发的顶尖开源模型,凭借其出色的代码能力和推理性能,受到开发者和技术爱好者的广泛关注。与此同时,用户友好的客户端应用也在不断涌现,以满足日常使用需求,其中Chatbox作为一款免费开源的跨平台AI聊天客户端,支持丰富的大模型接入,成为许多用户的首选。

本文将详细介绍如何在Chatbox中配置和使用DeepSeek-R1模型,包括本地部署和API接入两种方法,帮助读者根据自身设备条件和使用需求,选择最适合的方式。无论您是专业开发者还是AI爱好者,都能从本指南中找到有价值的内容。

一、DeepSeek-R1模型介绍

1.1 DeepSeek-R1的核心特点

DeepSeek-R1是由深度求索(DeepSeek)团队于2024年发布的开源大型语言模型,它具有以下几个突出特点:

- 强大的代码生成能力:在代码相关的基准测试中表现优异,尤其擅长处理复杂的编程任务

- 出色的推理能力:在数学和逻辑推理能力测试中表现突出,能够处理复杂的问题分析

- 丰富的编程语言支持:良好支持Python、JavaScript、Java、C++等主流编程语言

- 多种参数规模:提供1B到20B多个参数规模的模型版本,可根据部署环境选择适合的大小

- 开源许可:采用宽松的开源许可,允许商业使用和二次开发

1.2 DeepSeek-R1与其他模型对比

相比同时期的其他开源模型,DeepSeek-R1在以下几个方面具有明显优势:

- 在HumanEval和MBPP等代码生成基准测试中,显著优于同等参数规模的其他开源模型

- 专注于编程领域,在代码生成和理解方面优化更为明显

- 推理能力更强,能够处理需要多步骤思考的复杂问题

- 对中文编程场景有较好的适配,理解中文编程指令的能力突出

二、Chatbox客户端概述

2.1 Chatbox特点介绍

Chatbox是一款开源的跨平台AI聊天应用,支持Windows、MacOS和Linux系统,具有以下特点:

- 完全免费开源:无需付费,完全开源,代码托管在GitHub上

- 支持多种大模型:除了常见的OpenAI、Anthropic、Google模型外,还支持本地部署的开源模型

- 自定义模型提供商:允许用户添加自定义API端点和模型配置

- 多会话管理:支持创建和管理多个聊天会话,便于不同任务分类

- 代码高亮显示:自动识别和高亮显示代码块,提升阅读体验

- Prompt模板管理:内置Prompt模板系统,可保存和复用常用提示词

- 导出对话记录:支持多种格式导出聊天记录,便于存档和分享

2.2 安装Chatbox

在开始配置DeepSeek-R1之前,首先需要安装Chatbox客户端:

- 访问Chatbox的GitHub仓库:https://github.com/Bin-Huang/chatbox

- 在Releases页面下载最新版本的安装包:

- Windows用户:下载.exe安装文件

- MacOS用户:下载.dmg安装文件

- Linux用户:下载.AppImage或.deb安装文件

- 按照操作系统的常规步骤安装应用程序

- 安装完成后,启动Chatbox应用

三、本地部署DeepSeek-R1(通过Ollama)

3.1 Ollama简介

Ollama是一款简化本地大语言模型部署和运行的工具,它提供了一种简单的方式来下载、配置和运行各种开源LLMs,包括DeepSeek-R1。通过Ollama,即使没有深厚的技术背景,也能在本地设备上运行这些强大的AI模型。

3.2 安装Ollama

根据您的操作系统,选择相应的安装方法:

Windows安装

- 访问Ollama官方下载页面

- 下载Windows安装包并运行

- 按照安装向导完成安装

- 安装完成后,Ollama会作为系统服务在后台运行

MacOS安装

- 访问Ollama官方下载页面

- 下载MacOS安装包(.dmg文件)

- 打开下载的.dmg文件,将Ollama拖到Applications文件夹

- 从应用程序启动Ollama

Linux安装

curl -fsSL https://ollama.com/install.sh | sh3.3 下载DeepSeek-R1模型

安装完Ollama后,需要下载DeepSeek-R1模型:

- 打开终端或命令提示符

- 执行以下命令:

ollama pull deepseek-coder:latest - 等待模型下载完成(模型大小约为几GB到十几GB,取决于具体版本,下载时间取决于网络速度)

3.4 在Chatbox中配置Ollama连接

- 打开Chatbox应用

- 点击左侧的设置图标,进入设置界面

- 在”模型提供商”部分,点击”添加”按钮

- 填写以下信息:

- 名称:Ollama

- 基础URL:http://localhost:11434/api

- 点击”保存”按钮

- 在左侧对话界面,创建新对话或选择现有对话

- 在对话界面顶部的模型选择下拉菜单中,找到并选择”deepseek-coder”模型

- 现在您可以开始与DeepSeek-R1模型对话了

3.5 Ollama本地部署的优化建议

为了获得更好的本地使用体验,可以考虑以下优化措施:

- GPU加速:如果有支持CUDA的NVIDIA显卡,Ollama会自动使用GPU加速。确保已安装最新的NVIDIA驱动和CUDA工具包

- 内存配置:DeepSeek-R1需要较大内存,建议设备至少有16GB RAM,理想情况下32GB或更多

- 模型量化:可以使用量化版本的模型以减少内存占用,例如:

ollama pull deepseek-coder:6b-instruct-q4_0 - 调整上下文窗口:根据设备性能调整上下文窗口大小,可以在Chatbox的设置中修改

四、通过API连接DeepSeek-R1

4.1 API接入的优势

虽然本地部署为模型使用提供了私密性和完全控制权,但API接入方式具有以下明显优势:

- 无需高配置硬件:即使是普通笔记本或台式机也能流畅使用

- 无需大量下载:避免下载几GB甚至几十GB的模型文件

- 更快的响应速度:云端服务器通常配备专业级GPU,响应速度快

- 无本地资源占用:不占用本地GPU和内存资源

- 随时可用:无需等待模型加载,即开即用

- 跨设备一致体验:在任何设备上体验都一致

4.2 laozhang.ai API服务介绍

laozhang.ai提供了性价比极高的大语言模型API中转服务,具有以下特点:

- 全面的模型支持:支持OpenAI、Anthropic、Google、DeepSeek等多家厂商的主流模型

- 稳定可靠:采用全球分布式节点,确保API访问稳定快速

- 性价比高:相比直接使用官方API,价格更加亲民

- 即开即用:注册后立即获得免费额度,可以马上开始使用

- 完全兼容:与官方API完全兼容,无需调整现有代码

- 无需复杂配置:简单设置即可在Chatbox等各类应用中使用

4.3 注册并获取laozhang.ai API密钥

- 访问https://api.laozhang.ai注册账号

- 完成邮箱验证并登录账户

- 在用户控制台,找到”API密钥”部分

- 点击”创建API密钥”按钮生成新的密钥

- 复制并安全保存生成的API密钥

4.4 在Chatbox中配置laozhang.ai API

按照以下步骤配置Chatbox以使用laozhang.ai API访问DeepSeek-R1模型:

- 打开Chatbox应用

- 点击左侧的设置图标,进入设置界面

- 在”模型提供商”部分,点击”添加”按钮

- 填写以下信息:

- 名称:自定义名称,例如”laozhang.ai DeepSeek”

- 基础URL:https://api.laozhang.ai/v1

- API密钥:粘贴您从laozhang.ai获取的API密钥

- 在模型列表中添加:deepseek-r1

- 点击”保存”按钮

- 返回聊天界面,在模型选择下拉菜单中,选择刚刚添加的DeepSeek-R1模型

- 现在您可以开始通过API使用DeepSeek-R1模型了

五、DeepSeek-R1最佳使用实践

5.1 针对不同任务的参数设置

DeepSeek-R1的性能可以通过调整不同参数来优化,以下是针对常见任务的推荐设置:

编程任务

- 温度(Temperature):0.1-0.3,低温度使输出更确定,代码更准确

- 最大输出长度:根据需求调整,复杂代码建议设置为8000以上

- Top P:0.95,保持输出的确定性

创意写作

- 温度:0.7-0.9,较高的温度使输出更多样化和创意

- Top P:0.9,允许更多样化的词汇选择

技术文档生成

- 温度:0.3-0.5,平衡确定性和流畅性

- 最大输出长度:根据文档长度需求调整

5.2 高级Prompt技巧

有效的Prompt设计可以显著提升DeepSeek-R1的输出质量:

代码生成Prompt模板

你是一名专业的[编程语言]开发者。请帮我实现一个[功能描述]的程序。

要求:

1. 代码必须高效、简洁,并附带必要的注释

2. 考虑边界情况和异常处理

3. 使用模块化设计

4. 遵循[编程语言]的最佳实践

具体功能描述:[详细描述]代码调试Prompt模板

以下代码存在问题:

```[编程语言]

[有问题的代码]

```

错误信息:[错误信息]

请帮我分析问题所在,并提供修复方案,同时解释问题的原因。5.3 Chatbox高级功能应用

配合DeepSeek-R1,Chatbox的以下高级功能可以提升使用体验:

- 会话模式保存:将针对特定编程语言或任务的会话配置保存为模板,方便下次快速使用

- 多会话分组:为不同编程项目创建专门的会话组,保持工作流的组织性

- 代码导出:将生成的代码直接导出到文件,避免复制粘贴的麻烦

- 上下文管理:合理使用”清除上下文”功能,避免上下文过长影响性能

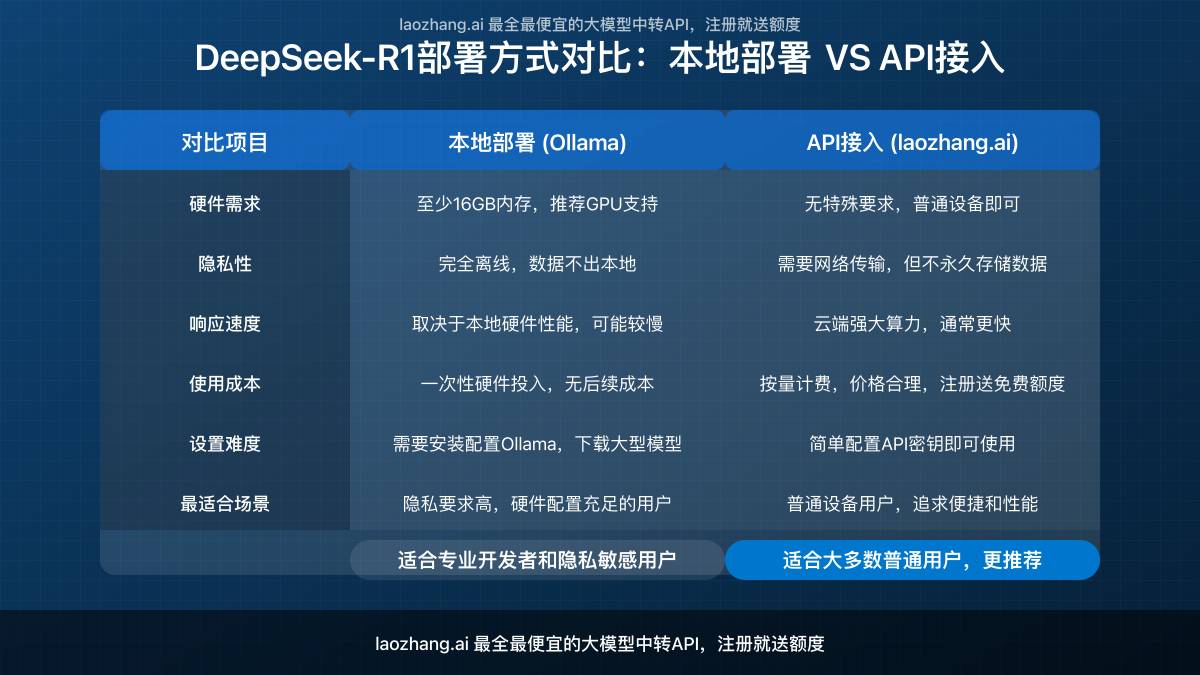

六、本地部署VS API接入:如何选择?

6.1 选择依据

根据以下因素选择最适合的部署方式:

推荐使用API接入的情况

- 普通笔记本或台式机用户,硬件配置有限

- 不希望下载大型模型文件的用户

- 需要即时使用,不愿等待模型加载的场景

- 对成本敏感,不想投入高端硬件的用户

- 多设备使用需求强的用户

推荐本地部署的情况

- 拥有高端GPU(如RTX 3080及以上)的用户

- 对数据隐私有极高要求的场景

- 网络环境不稳定的地区

- 需要对模型进行深度定制的专业用户

6.2 两种方式的配合使用

实际上,许多高级用户会同时配置这两种方式,根据不同场景灵活切换:

- 在有稳定网络的工作环境中使用API接入

- 在需要处理敏感数据时切换到本地部署

- 在移动设备上使用API,在强力工作站上使用本地部署

七、常见问题及解答

Q1: DeepSeek-R1相比ChatGPT有哪些优势和劣势?

A: DeepSeek-R1作为开源模型,最大优势是可以本地部署和定制化,特别在代码生成和理解方面表现突出。相比ChatGPT,其总体能力略逊,但在特定编程任务上表现接近或超过ChatGPT 3.5。

Q2: 我的电脑配置较低,能否本地运行DeepSeek-R1?

A: DeepSeek-R1的完整版需要较高配置才能流畅运行。如果您的配置较低,建议:1)尝试量化版本的模型;2)使用API接入方式,如通过laozhang.ai提供的API服务,不占用本地资源。

Q3: 通过laozhang.ai API使用DeepSeek-R1的速度怎么样?

A: laozhang.ai采用全球分布式部署,响应速度通常比普通家用电脑本地部署更快。大多数用户反馈响应时间在1秒左右,流畅度超过本地部署。

Q4: laozhang.ai的API计费方式是怎样的?

A: laozhang.ai采用按使用量计费的模式,新用户注册即赠送免费额度。相比官方API,价格更为经济,具体计费细则可在官网查询。

Q5: DeepSeek-R1适合处理哪些类型的编程任务?

A: DeepSeek-R1在算法设计、代码实现、调试和重构方面表现出色,特别适合处理Python、JavaScript、Java、C++等主流语言的编程任务,对解决常见编程问题、生成标准代码片段、分析代码缺陷等场景尤为适用。

结语

通过本指南,您已经掌握了在Chatbox中使用DeepSeek-R1的两种主要方法。对于大多数普通用户,我们推荐使用laozhang.ai提供的API服务,它提供了便捷、高效且经济的使用体验,无需考虑硬件限制,即可享受DeepSeek-R1的强大功能。

随着大语言模型技术的不断发展,像DeepSeek-R1这样的开源模型将继续提升性能,为更多开发者和技术爱好者提供强大的AI辅助工具。通过合理选择部署方式和优化使用技巧,您可以最大化发挥DeepSeek-R1的潜力,提升编程和创作效率。

如果您在使用过程中遇到任何问题,欢迎访问laozhang.ai获取更多技术支持和资源。