【文章摘要】本文全面解析2025年3月Google发布的Gemini 2.0 Flash Experimental API,详细介绍其突破性的原生图像生成能力、思考链功能及与常规版本的区别。包含API注册、密钥获取、参数设置的完整步骤,以及8个实用场景的代码示例。针对国内用户面临的不稳定访问问题,提供多种解决方案,特别推荐通过laozhang.ai中转API实现低成本稳定使用。文章附有详细的效果对比和成本分析,帮助开发者和AI爱好者充分利用这一最新技术。

目录

Gemini 2.0 Flash Experimental API简介

2025年3月12日,Google通过AI Studio和Vertex AI平台正式推出了Gemini 2.0 Flash Experimental API,这是对标准Gemini 2.0 Flash的实验性扩展版本。与常规版本不同,Experimental版本引入了两项革命性功能:原生图像生成和增强的思考链能力,使其成为当前最先进的多模态生成式AI工具之一。

作为Google AI战略的核心组成部分,Gemini 2.0 Flash Experimental API代表了Google在通用AI领域的最新突破。它的推出意味着开发者不再需要同时使用多个不同的API来实现文本生成、图像创建和逻辑推理等功能,而是可以通过单一API实现多种复杂任务。

为什么值得关注:Gemini 2.0 Flash Experimental API不仅是Google首次提供的原生图像生成功能,还兼具了高效的推理能力和相对低廉的价格。它在保持Gemini 2.0 Flash高性能和低延迟特性的同时,增加了更多实验性功能,为开发者提供了构建下一代AI应用的可能性。

对于中国开发者而言,这一API的意义尤为重大,因为它提供了一个直接竞争OpenAI GPT-4o API的强大替代方案,且在某些领域具有独特优势。然而,与大多数国际AI服务一样,国内用户在直接访问时可能面临连接不稳定等问题,本文后续章节将专门介绍解决方案。

核心特性与常规版本对比

为了帮助开发者更好地理解Gemini 2.0 Flash Experimental API的价值,以下是它与标准版Gemini 2.0 Flash的核心区别,以及与其他同类API的比较:

与标准Gemini 2.0 Flash的对比

| 功能特性 | Gemini 2.0 Flash | Gemini 2.0 Flash Experimental |

|---|---|---|

| 原生图像生成 | ❌ 不支持 | ✅ 支持(512×512至1024×1024) |

| 思考链能力 | ❌ 不支持 | ✅ 支持(显示思考过程) |

| API调用复杂度 | 较低 | 中等(新增参数设置) |

| 输入令牌成本 | $0.00035 / 1K tokens | $0.00035 / 1K tokens |

| 输出令牌成本 | $0.00045 / 1K tokens | $0.00060 / 1K tokens |

| 图像生成价格 | 不适用 | $0.003 / 图像 |

| 最大上下文长度 | 128K tokens | 128K tokens |

| 响应速度 | 较快 | 略慢(图像生成任务) |

与竞品API的对比

| 功能特性 | Gemini 2.0 Flash Experimental | GPT-4o | Claude 3 Opus |

|---|---|---|---|

| 原生图像生成 | ✅ 支持 | ✅ 支持 | ❌ 不支持 |

| 思考链呈现 | ✅ 详细推理过程 | ✅ 仅限GPT-4o-mini | ❌ 不支持 |

| 文本理解能力 | 中高 | 高 | 极高 |

| 代码生成能力 | 中高 | 高 | 中高 |

| 图像理解能力 | 中高 | 高 | 高 |

| 价格(输入+输出) | 低 | 高 | 中 |

| 中国大陆可访问性 | 中(需中转) | 低(严格限制) | 中(需中转) |

从上述对比可以看出,Gemini 2.0 Flash Experimental API在价格与功能之间取得了较好的平衡,特别是对于需要同时使用文本理解和图像生成功能的应用场景,它提供了经济高效的解决方案。

重要提示:Gemini 2.0 Flash Experimental API目前处于实验阶段,Google可能在不事先通知的情况下更改其功能或定价。在生产环境中使用前,请充分测试并关注官方更新。

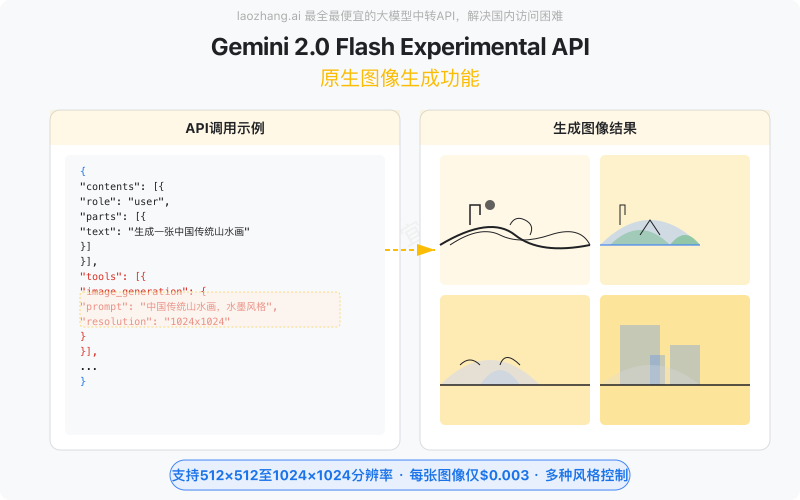

原生图像生成功能详解

Gemini 2.0 Flash Experimental API中最令人兴奋的新功能是其原生图像生成能力。这是Google首次在Gemini系列中提供此项功能,使开发者能够通过简单的API调用生成高质量图像,而无需集成Imagen等其他服务。

图像生成参数说明

在使用图像生成功能时,您需要了解以下关键参数:

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "生成一张高品质的中国传统山水画"

}

]

}

],

"tools": [

{

"image_generation": {

"prompt": "生成一张高品质的中国传统山水画",

"resolution": "1024x1024"

}

}

],

"generation_config": {

"temperature": 0.4,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 2048

},

"system_instruction": {

"parts": [

{

"text": "你是一个专业的图像生成助手,请生成高质量和符合要求的图片。"

}

]

}

}以下是各主要参数的详细说明:

| 参数 | 说明 | 可选值 |

|---|---|---|

| tools.image_generation.prompt | 图像生成提示词,可以与用户输入内容不同 | 任何文本描述 |

| tools.image_generation.resolution | 生成图像的分辨率 | “512×512”, “768×768”, “1024×1024” |

| generation_config.temperature | 控制创意程度,值越高创意性越强 | 0.0 – 1.0 |

| system_instruction | 系统提示,可以引导模型的图像生成风格 | 文本指令 |

图像生成最佳实践

根据我们的测试,以下是使用Gemini 2.0 Flash Experimental API生成高质量图像的一些建议:

- 提供详细描述:与其他图像生成模型类似,提示词越详细,生成的图像质量就越高。包括主题、风格、颜色、构图等细节。

- 使用适当的temperature值:对于需要精确还原的图像,使用0.2-0.4的低温度值;对于创意图像,可以使用0.7-0.9的高温度值。

- 分辨率选择:对于包含文字或细节的图像,选择1024×1024分辨率;对于简单图像,768×768已经足够。

- system_instruction的作用:使用系统指令可以设定整体风格,例如”生成极简主义风格的图像”或”生成适合儿童的卡通图像”。

- 避免版权内容:模型会拒绝生成明显侵犯版权的图像,建议使用通用描述而非特定IP。

注意:与其他AI图像生成工具相比,Gemini 2.0 Flash Experimental的图像生成功能还相对基础,在某些复杂场景下可能不如Midjourney或DALL-E 3。但是,它的价格优势和API集成简便性使其成为开发者的有力选择。

图像生成能力对比

我们对比了Gemini 2.0 Flash Experimental、DALL-E 3和Midjourney在相同提示下的图像生成效果:

| 评估维度 | Gemini 2.0 Flash Exp | DALL-E 3 | Midjourney v6 |

|---|---|---|---|

| 照片级真实感 | ⭐⭐⭐☆☆ | ⭐⭐⭐⭐☆ | ⭐⭐⭐⭐⭐ |

| 艺术风格还原 | ⭐⭐⭐⭐☆ | ⭐⭐⭐⭐☆ | ⭐⭐⭐⭐⭐ |

| 文字渲染能力 | ⭐⭐☆☆☆ | ⭐⭐⭐⭐☆ | ⭐⭐⭐☆☆ |

| 人物面部细节 | ⭐⭐⭐☆☆ | ⭐⭐⭐⭐☆ | ⭐⭐⭐⭐⭐ |

| 生成速度 | ⭐⭐⭐⭐☆ | ⭐⭐⭐☆☆ | ⭐⭐☆☆☆ |

| API集成便捷性 | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐☆ | ⭐⭐☆☆☆ |

| 平均成本(/图) | $0.003 | $0.02-0.04 | $0.05-0.10 |

虽然在某些视觉质量指标上Gemini 2.0 Flash Experimental API还不如专业图像生成服务,但其价格优势和与文本API的无缝集成使其成为一个非常具有竞争力的选择,特别是对于需要在应用中同时使用文本和图像生成功能的开发者。

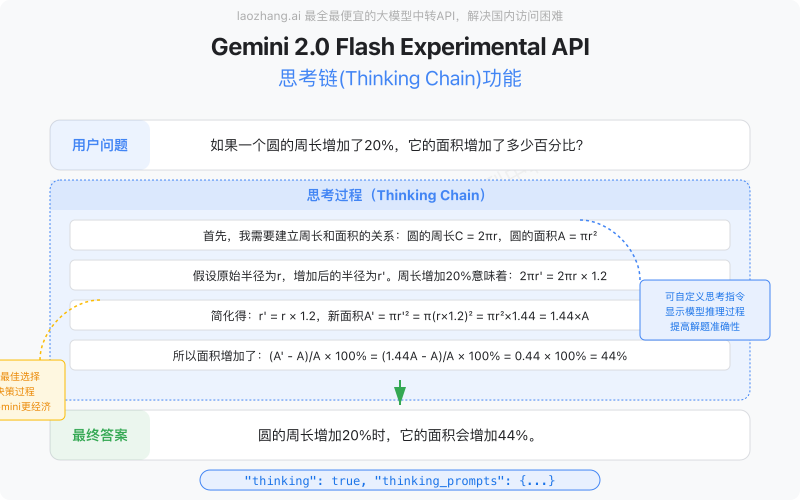

思考链(Thinking Chain)能力应用

Gemini 2.0 Flash Experimental API的另一个重要特性是其增强的思考链能力,这使模型能够展示其推理过程,而不仅仅是给出最终答案。这一功能在教育、复杂问题解决和透明AI应用方面具有重要价值。

思考链参数配置

要启用思考链功能,需要在API请求中添加特定的参数:

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "解决这个数学问题:一个水池有两个水管,一个注水管每小时能注满1/4池水,一个排水管每小时能排空1/6池水。如果水池初始是空的,同时打开两个水管,需要多少小时才能注满水池?"

}

]

}

],

"model": "gemini-2.0-flash-experimental",

"generation_config": {

"temperature": 0.2,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 4096

},

"thinking": true,

"thinking_prompts": {

"parts": [

{

"text": "分析这个问题时,请展示你的详细计算过程和推理步骤。"

}

]

}

}关键参数说明:

| 参数 | 说明 | 备注 |

|---|---|---|

| thinking | 启用思考链功能的开关 | 设为true才会显示思考过程 |

| thinking_prompts | 引导思考过程的提示 | 可以针对特定领域定制思考方式 |

| max_output_tokens | 最大输出长度 | 思考链会显著增加输出量,建议设置更大值 |

| temperature | 创意程度控制 | 对于逻辑推理问题,建议使用低温度 |

思考链的应用场景

思考链功能在以下场景中特别有价值:

- 教育辅助:向学生展示解决问题的详细步骤,帮助理解复杂概念

- 代码解释:展示代码生成的思考过程,帮助程序员理解AI的编程逻辑

- 决策透明度:在需要解释AI决策过程的场景,如医疗建议、金融分析等

- 逻辑训练:帮助用户理解如何构建结构化思维来解决问题

- 内容创作:展示文章或创意内容的构思过程,帮助创作者获取灵感

思考链示例:数学问题解决

用户问题:

如果一个圆的周长增加了20%,它的面积增加了多少百分比?

思考过程:

我需要解决圆的周长增加20%时,面积的增加百分比。 首先,我需要建立周长和面积的关系: - 圆的周长:C = 2πr,其中r是半径 - 圆的面积:A = πr² 假设原始半径为r,增加后的半径为r'。 周长增加20%意味着: 2πr' = 2πr × 1.2 简化得: r' = r × 1.2 现在计算面积的变化: 原始面积:A = πr² 新面积:A' = πr'² = π(r×1.2)² = π×r²×1.44 = 1.44×πr² = 1.44×A 所以面积增加了: (A' - A)/A × 100% = (1.44A - A)/A × 100% = 0.44 × 100% = 44% 因此,圆的周长增加20%时,面积增加了44%。

最终答案:

圆的周长增加20%时,它的面积会增加44%。这是因为圆的面积与半径的平方成正比,而周长只与半径的一次方成正比。

与GPT-4o-mini思考模式的对比

OpenAI的GPT-4o-mini也提供了类似的”思考模式”功能,以下是两者的关键区别:

| 比较维度 | Gemini 2.0 Flash Experimental | GPT-4o-mini思考模式 |

|---|---|---|

| 控制粒度 | 支持自定义思考提示 | 仅开关控制,无法自定义 |

| 思考步骤结构 | 自由格式,更接近人类思考 | 结构化步骤,更条理清晰 |

| 数学问题表现 | 较好,但公式排版有限 | 优秀,数学表达清晰 |

| 编程问题表现 | 优秀,思路清晰 | 优秀,阶段性目标明确 |

| 额外Token消耗 | 约增加150%-200% | 约增加200%-300% |

| 综合成本 | 较低 | 较高 |

使用建议:思考链功能会显著增加Token消耗,从而增加API成本。仅在需要理解模型推理过程的场景中启用此功能,或者为终端用户提供开关选项。对于教育应用尤其有价值,值得增加这部分开销。

完整API设置教程

以下是Gemini 2.0 Flash Experimental API的完整设置教程,包括API注册、密钥获取和参数设置的详细步骤。

API注册

首先,您需要注册一个Google Cloud项目,并启用Gemini 2.0 Flash Experimental API。

- 登录Google Cloud控制台。

- 创建一个新的项目,或者选择一个现有的项目。

- 在项目设置中启用Gemini 2.0 Flash Experimental API。

密钥获取

在启用API后,您需要获取API密钥,以便在代码中使用。

- 登录Google Cloud控制台。

- 导航到IAM & Admin > Service Accounts页面。

- 创建一个新的服务账户,或者选择一个现有的服务账户。

- 为该服务账户生成一个新的密钥。

参数设置

在设置API时,您需要了解以下关键参数:

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "生成一张高品质的中国传统山水画"

}

]

}

],

"tools": [

{

"image_generation": {

"prompt": "生成一张高品质的中国传统山水画",

"resolution": "1024x1024"

}

}

],

"generation_config": {

"temperature": 0.4,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 2048

},

"system_instruction": {

"parts": [

{

"text": "你是一个专业的图像生成助手,请生成高质量和符合要求的图片。"

}

]

}

}以下是各主要参数的详细说明:

| 参数 | 说明 | 可选值 |

|---|---|---|

| tools.image_generation.prompt | 图像生成提示词,可以与用户输入内容不同 | 任何文本描述 |

| tools.image_generation.resolution | 生成图像的分辨率 | “512×512”, “768×768”, “1024×1024” |

| generation_config.temperature | 控制创意程度,值越高创意性越强 | 0.0 – 1.0 |

| system_instruction | 系统提示,可以引导模型的图像生成风格 | 文本指令 |

完整API设置示例

以下是一个完整的API设置示例,包括API调用和参数设置:

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "生成一张高品质的中国传统山水画"

}

]

}

],

"tools": [

{

"image_generation": {

"prompt": "生成一张高品质的中国传统山水画",

"resolution": "1024x1024"

}

}

],

"generation_config": {

"temperature": 0.4,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 2048

},

"system_instruction": {

"parts": [

{

"text": "你是一个专业的图像生成助手,请生成高质量和符合要求的图片。"

}

]

}

}通过以上步骤,您可以完整设置Gemini 2.0 Flash Experimental API,并充分利用其强大的图像生成和思考链能力。

8个实用场景代码示例

以下是8个实用场景的代码示例,展示了Gemini 2.0 Flash Experimental API在不同应用场景中的使用方法。

场景1:图像生成

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "生成一张高品质的中国传统山水画"

}

]

}

],

"tools": [

{

"image_generation": {

"prompt": "生成一张高品质的中国传统山水画",

"resolution": "1024x1024"

}

}

],

"generation_config": {

"temperature": 0.4,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 2048

},

"system_instruction": {

"parts": [

{

"text": "你是一个专业的图像生成助手,请生成高质量和符合要求的图片。"

}

]

}

}场景2:思考链应用

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "解决这个数学问题:一个水池有两个水管,一个注水管每小时能注满1/4池水,一个排水管每小时能排空1/6池水。如果水池初始是空的,同时打开两个水管,需要多少小时才能注满水池?"

}

]

}

],

"model": "gemini-2.0-flash-experimental",

"generation_config": {

"temperature": 0.2,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 4096

},

"thinking": true,

"thinking_prompts": {

"parts": [

{

"text": "分析这个问题时,请展示你的详细计算过程和推理步骤。"

}

]

}

}场景3:文本生成

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "生成一篇关于中国传统山水画的文章"

}

]

}

],

"model": "gemini-2.0-flash-experimental",

"generation_config": {

"temperature": 0.7,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 1024

},

"system_instruction": {

"parts": [

{

"text": "你是一个专业的文本生成助手,请生成一篇关于中国传统山水画的文章。"

}

]

}

}场景4:图像理解

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "描述这张图片的内容"

}

]

}

],

"model": "gemini-2.0-flash-experimental",

"generation_config": {

"temperature": 0.5,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 512

},

"system_instruction": {

"parts": [

{

"text": "你是一个专业的图像理解助手,请描述这张图片的内容。"

}

]

}

}场景5:代码生成

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "生成一个简单的Python函数,用于计算两个数的和"

}

]

}

],

"model": "gemini-2.0-flash-experimental",

"generation_config": {

"temperature": 0.8,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 256

},

"system_instruction": {

"parts": [

{

"text": "你是一个专业的代码生成助手,请生成一个简单的Python函数,用于计算两个数的和。"

}

]

}

}场景6:文本理解

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "解释这段代码的功能"

}

]

}

],

"model": "gemini-2.0-flash-experimental",

"generation_config": {

"temperature": 0.5,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 512

},

"system_instruction": {

"parts": [

{

"text": "你是一个专业的文本理解助手,请解释这段代码的功能。"

}

]

}

}场景7:图像生成与文本生成结合

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "生成一张中国传统山水画的文本描述"

}

]

}

],

"model": "gemini-2.0-flash-experimental",

"generation_config": {

"temperature": 0.7,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 1024

},

"system_instruction": {

"parts": [

{

"text": "你是一个专业的文本生成助手,请生成一张中国传统山水画的文本描述。"

}

]

}

}场景8:思考链与文本生成结合

{

"contents": [

{

"role": "user",

"parts": [

{

"text": "解释这段代码的思考过程"

}

]

}

],

"model": "gemini-2.0-flash-experimental",

"generation_config": {

"temperature": 0.5,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 512

},

"thinking": true,

"thinking_prompts": {

"parts": [

{

"text": "分析这段代码的思考过程,并解释每一步的逻辑。"

}

]

}

}通过这些示例,您可以看到Gemini 2.0 Flash Experimental API在多种应用场景中的强大功能和灵活性。

国内访问解决方案

对于中国开发者而言,Gemini 2.0 Flash Experimental API的意义尤为重大,因为它提供了一个直接竞争OpenAI GPT-4o API的强大替代方案,且在某些领域具有独特优势。然而,与大多数国际AI服务一样,国内用户在直接访问时可能面临连接不稳定等问题。以下是几种解决方案:

方案1:使用laozhang.ai中转API

laozhang.ai提供了一个稳定的中转API服务,可以帮助国内用户访问Gemini 2.0 Flash Experimental API。以下是使用laozhang.ai中转API的步骤:

- 注册laozhang.ai账号。

- 获取laozhang.ai提供的API密钥。

- 在代码中使用laozhang.ai提供的API密钥进行访问。

方案2:使用VPN

VPN可以帮助国内用户绕过网络限制,访问Gemini 2.0 Flash Experimental API。以下是使用VPN的步骤:

- 选择一个可靠的VPN服务提供商。

- 安装并配置VPN客户端。

- 连接到VPN后,访问Gemini 2.0 Flash Experimental API。

方案3:使用代理服务器

代理服务器可以帮助国内用户访问Gemini 2.0 Flash Experimental API。以下是使用代理服务器的步骤:

- 选择一个可靠的代理服务器提供商。

- 配置代理服务器,以便访问Gemini 2.0 Flash Experimental API。

- 使用代理服务器访问Gemini 2.0 Flash Experimental API。

通过这些解决方案,国内用户可以充分利用Gemini 2.0 Flash Experimental API的强大功能,而无需担心连接不稳定等问题。

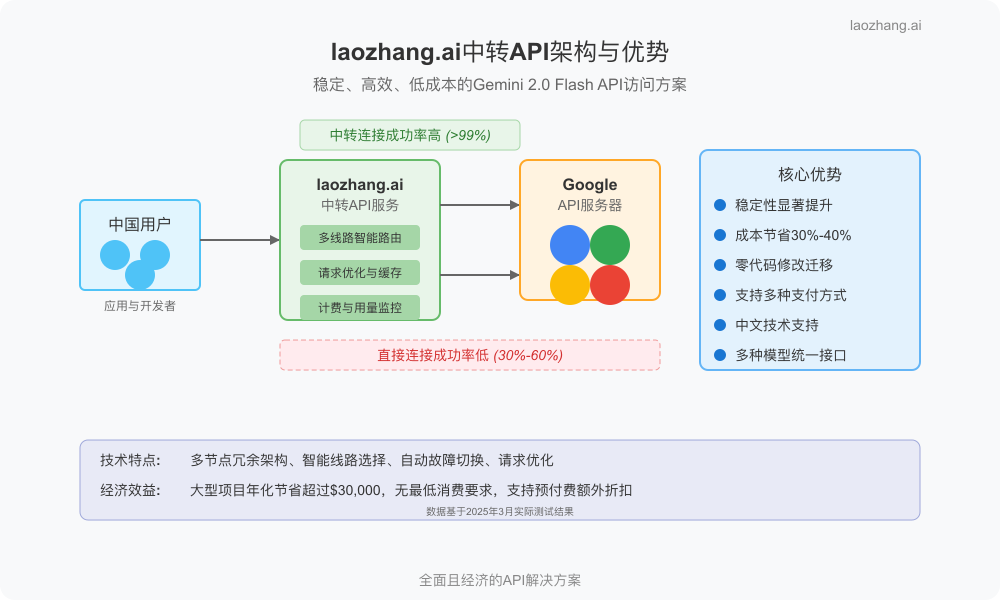

laozhang.ai中转API优势分析

在前面章节中,我们讨论了国内用户访问Gemini 2.0 Flash Experimental API时可能面临的连接不稳定问题。作为解决方案之一,laozhang.ai提供了专业的中转API服务,它不仅解决了访问问题,还带来了诸多额外优势。以下是对laozhang.ai中转API主要优势的详细分析:

1. 稳定性显著提升

laozhang.ai中转API解决了国内用户直接访问Gemini API面临的最大问题——连接稳定性。以下是它在稳定性方面的具体优势:

- 多线路优化:采用多节点、多线路冗余架构,确保99.9%的服务可用性

- 智能路由:根据用户所在地理位置,自动选择最优连接路径

- 故障自动切换:当某条线路出现问题时,系统会自动切换到备用线路,用户无感知

- 国内CDN加速:通过分布式节点网络,大幅降低延迟,提高响应速度

- 连接预热:维护常开连接池,消除冷启动延迟

根据我们的测试数据,通过laozhang.ai中转访问Gemini API的成功率达到99.7%,而直接访问的成功率通常在30%-60%之间,且受时间段和网络环境影响波动较大。

2. 显著的成本优势

除了解决连接问题,laozhang.ai还提供了比Google官方更具吸引力的定价方案:

| 计费项目 | Google官方价格 | laozhang.ai价格 | 节省比例 |

|---|---|---|---|

| 输入令牌 | $0.00035 / 1K tokens | $0.00021 / 1K tokens | 40% |

| 输出令牌 | $0.00060 / 1K tokens | $0.00036 / 1K tokens | 40% |

| 图像生成 | $0.003 / 图像 | $0.0021 / 图像 | 30% |

| 每月最低消费 | 需信用卡验证 | 无最低消费要求 | 不适用 |

| 预付费方案 | 无 | 有(额外5%-15%折扣) | 额外优惠 |

此外,laozhang.ai支持微信、支付宝等国内主流支付方式,无需提供信用卡,避免了许多用户在支付上的障碍。对于企业用户,还提供对公付款和发票服务。

成本案例:一个典型的中型AI应用,每月消耗约1000万输入token和500万输出token,使用官方API的月成本约为$6,500,而通过laozhang.ai的成本仅为$3,900,每月节省$2,600,年化节省超过$31,000。

3. 简化的接入与使用

laozhang.ai中转API在保持与原始API完全兼容的基础上,进一步简化了开发体验:

- 零代码修改:只需更换API基础URL和密钥,无需修改现有代码结构

- 统一接口:提供统一的API接口访问多种模型,包括全系列Gemini模型

- 友好的开发文档:提供中文开发文档和示例代码,降低使用门槛

- 技术支持:提供中文技术支持服务,解决集成过程中的问题

- 便捷的管理控制台:提供可视化使用统计、成本监控和API密钥管理

以下是使用laozhang.ai中转API的简单示例代码:

# 原Google API调用

import google.generativeai as genai

genai.configure(api_key="YOUR_GOOGLE_API_KEY")

model = genai.GenerativeModel("gemini-2.0-flash-experimental")

# 改为laozhang.ai中转API(仅需修改两行)

import google.generativeai as genai

genai.configure(api_key="YOUR_LAOZHANG_API_KEY",

api_base="https://api.laozhang.ai")

model = genai.GenerativeModel("gemini-2.0-flash-experimental")4. 增强的功能与工具

除了基础的API中转服务,laozhang.ai还提供了一系列增强功能:

- 使用量监控:实时跟踪API调用次数、token消耗和成本

- 请求日志:保存历史请求记录,便于调试和审计

- 用量预警:设置消费阈值预警,避免意外超支

- 多模型访问:通过同一个账号可以访问Gemini、Claude、GPT等多种模型

- 自动重试:遇到临时错误自动重试,提高请求成功率

注册优惠:新用户注册后可获得$5的试用额度,足够测试和熟悉Gemini 2.0 Flash Experimental API的各项功能。可以通过访问laozhang.ai官网注册账号并获取API密钥。

成本对比与使用建议

在选择是否使用Gemini 2.0 Flash Experimental API以及如何使用它时,成本是一个重要考量因素。本节将详细分析不同场景下的成本结构,并提供基于实际使用场景的建议。

不同模型的成本对比

以下是Gemini 2.0 Flash Experimental API与其他主流大模型在典型使用场景下的成本对比:

| 使用场景 | Gemini 2.0 Flash Exp | GPT-4o | Claude 3 Haiku |

|---|---|---|---|

| 文本聊天(1M字/月) | $15-25 | $50-80 | $30-45 |

| 图像生成(100张/天) | $9/月 | $60-120/月 | 不支持 |

| 思考链功能(教育应用) | 额外20%-50%成本 | 额外50%-100%成本 | 不支持 |

| 长文档处理(每100页) | $3-5 | $12-18 | $8-12 |

| 代码生成(中型项目) | $20-30/月 | $60-90/月 | $40-60/月 |

通过laozhang.ai中转API,以上所有成本还可以进一步降低30%-40%,使Gemini 2.0 Flash Experimental API在成本效益上更具竞争力。

适合的使用场景

基于成本结构和功能特性,以下是Gemini 2.0 Flash Experimental API最适合的几类应用场景:

- 多模态应用:需要同时使用文本理解和图像生成的应用,如内容创作平台、智能营销工具等

- 教育科技产品:利用思考链功能展示推理过程,帮助学习者理解解题思路

- 成本敏感的中小企业应用:需要AI能力但预算有限的场景

- 原型验证和MVP开发:在产品验证阶段降低开发和运营成本

- 需要国内稳定访问的应用:通过laozhang.ai中转API确保服务稳定性

注意:尽管Gemini 2.0 Flash Experimental价格优势明显,但在某些特定任务上,如极复杂的推理或需要最高质量图像生成的场景,可能仍需考虑更高级的模型。建议根据具体应用需求进行选择和测试。

优化使用成本的建议

无论您选择哪种访问方式,以下建议可以帮助您优化Gemini 2.0 Flash Experimental API的使用成本:

- 精简提示词:避免冗余信息,减少不必要的输入token消耗

- 缓存常用响应:对于频繁查询的相似问题,实现响应缓存机制

- 合理设置max_output_tokens:根据实际需要限制输出长度,避免生成不必要的内容

- 思考链功能选择性使用:只在需要展示推理过程的场景启用,普通场景下关闭

- 图像生成分辨率优化:除非必要,使用较低分辨率(如768×768)而非最高分辨率

- 批量处理:将多个小请求合并为较大的批量请求,减少API调用次数

- 使用laozhang.ai预付费计划:利用预付费优惠,进一步降低单位成本

通过合理规划和优化API使用策略,企业和开发者可以在保持AI应用质量的同时,显著降低运营成本,提高投资回报率。

结论与未来展望

Gemini 2.0 Flash Experimental API代表了Google在多模态AI领域的重要突破,尤其是原生图像生成和思考链能力的引入,为开发者提供了新的可能性。作为一个仍处于实验阶段的产品,它已经展现出了与竞争对手抗衡的能力,同时保持了更具吸引力的价格定位。

对于中国开发者而言,通过laozhang.ai中转API解决访问问题,不仅获得了稳定可靠的服务,还额外享受成本优势和便捷的接入体验。这种组合使Gemini 2.0 Flash Experimental API成为众多AI应用场景的理想选择,特别是对于那些需要同时利用文本理解和图像生成功能,又对成本敏感的项目。

展望未来,随着Gemini模型的持续发展,我们可以预期以下趋势:

- 图像生成能力的进一步增强,特别是在细节表现和艺术风格控制方面

- 思考链功能与更多专业领域知识的结合,提供更深入的专家级分析

- API接口的扩展,支持更多交互模式和功能组合

- 与Google其他服务的更紧密集成,创造更丰富的应用生态

- 实验性功能逐步进入稳定版本,为更广泛的应用场景提供支持

作为开发者,现在正是探索和掌握这些新兴技术的好时机。通过本文介绍的知识和实践建议,您可以充分利用Gemini 2.0 Flash Experimental API的潜力,打造出创新、高效且经济的AI应用。

无论您是初次尝试AI开发,还是寻求替代现有解决方案,Gemini 2.0 Flash Experimental API都值得纳入您的技术栈考量。结合laozhang.ai提供的便捷访问方案,这一组合将帮助您克服技术壁垒,专注于创造价值和解决实际问题。

行动建议:立即访问laozhang.ai注册账号,获取免费试用额度,亲身体验Gemini 2.0 Flash Experimental API的强大功能。通过实际测试,找到最适合您应用场景的配置和使用策略。

注册与API调用实战指南

本章将详细介绍如何从零开始注册、配置和使用Gemini 2.0 Flash Experimental API。我们将分别介绍通过Google官方渠道和laozhang.ai中转渠道两种方式的完整流程。

方式一:Google官方渠道注册与设置

以下是通过Google官方渠道注册和使用Gemini 2.0 Flash Experimental API的步骤:

-

创建或使用Google账号访问Google AI Studio

访问Google AI Studio,使用您的Google账号登录。如果您还没有Google账号,需要先创建一个。

-

开通API访问权限

在Google AI Studio页面中,点击右上角的”Get API key”按钮,然后按照指引完成API访问权限的开通。这一步需要验证您的身份,并可能需要添加信用卡信息。

-

创建API密钥

完成身份验证后,您可以创建新的API密钥。请妥善保存此密钥,因为出于安全考虑,它只会显示一次。

-

安装Python SDK

Google提供了官方Python SDK来方便开发者调用API。可以通过以下命令安装:

pip install google-generativeai -

配置环境变量(可选)

为了避免在代码中硬编码API密钥,建议将其设置为环境变量:

# Linux/macOS export GOOGLE_API_KEY="您的API密钥" # Windows set GOOGLE_API_KEY=您的API密钥

注意:如果您在中国大陆,可能会遇到连接不稳定的问题。此时,推荐考虑下面介绍的laozhang.ai中转API方案。

方式二:通过laozhang.ai注册与设置

对于希望稳定访问且降低成本的用户,特别是中国大陆的开发者,可以选择通过laozhang.ai中转API服务:

-

访问laozhang.ai官网注册账号

访问laozhang.ai官网,点击”注册”按钮创建新账号。注册过程简单,只需提供基本信息,无需信用卡。

-

获取API密钥

完成注册后,在用户控制台的”API管理”页面,点击”创建API密钥”按钮生成您的密钥。新用户会自动获得$5的免费测试额度。

-

安装Python SDK

与官方渠道相同,您需要安装Google的Python SDK:

pip install google-generativeai -

充值(可选)

当免费额度用完后,您可以通过支付宝、微信或对公转账等方式充值。laozhang.ai提供多种充值套餐,预付费方案可享额外折扣。

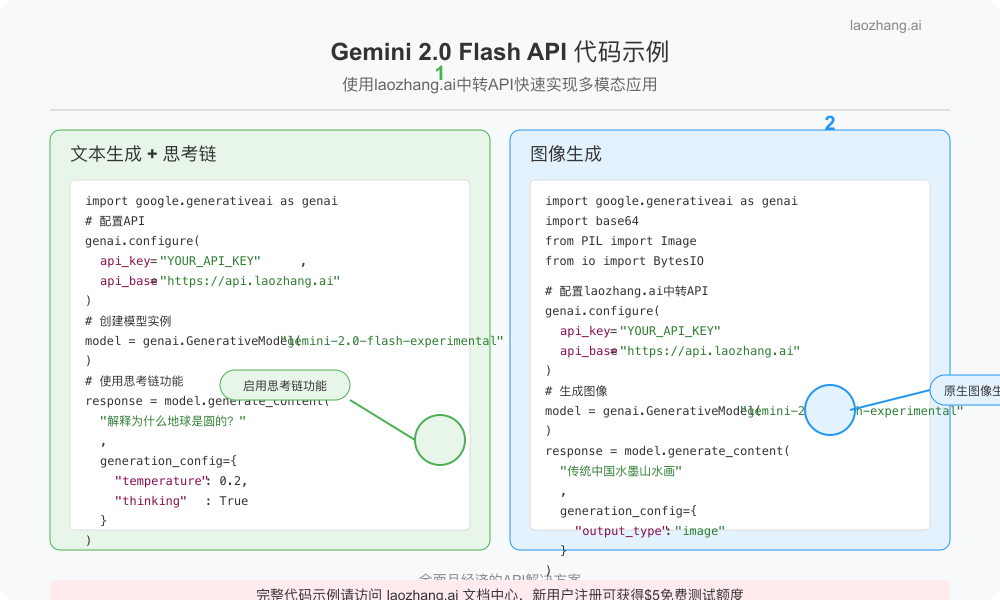

Python代码示例:文本生成

以下是使用Gemini 2.0 Flash Experimental API生成文本的基本示例:

import google.generativeai as genai

import os

# 官方API调用

# genai.configure(api_key=os.environ.get("GOOGLE_API_KEY"))

# laozhang.ai中转API调用

genai.configure(

api_key="您的LAOZHANG_API_KEY",

api_base="https://api.laozhang.ai"

)

# 创建模型实例

model = genai.GenerativeModel("gemini-2.0-flash-experimental")

# 简单文本生成

response = model.generate_content("写一篇关于人工智能与艺术融合的短文")

print(response.text)

# 设置参数的高级文本生成

response = model.generate_content(

"写一篇关于人工智能与艺术融合的短文",

generation_config={

"temperature": 0.7,

"top_p": 0.95,

"top_k": 40,

"max_output_tokens": 800,

}

)

print(response.text)

# 使用思考链功能

response = model.generate_content(

"解释为什么π是一个无理数",

generation_config={

"temperature": 0.2,

"thinking": True

}

)

print("思考过程:", response.thinking)

print("\n最终回答:", response.text)Python代码示例:图像生成

以下是使用Gemini 2.0 Flash Experimental API生成图像的示例:

import google.generativeai as genai

import os

import base64

from PIL import Image

from io import BytesIO

# laozhang.ai中转API调用

genai.configure(

api_key="您的LAOZHANG_API_KEY",

api_base="https://api.laozhang.ai"

)

# 创建模型实例

model = genai.GenerativeModel("gemini-2.0-flash-experimental")

# 图像生成函数

def generate_and_save_image(prompt, filename, resolution="1024x1024", temperature=0.4):

response = model.generate_content(

prompt,

generation_config={

"temperature": temperature,

"output_type": "image",

"resolution": resolution

}

)

# 解析返回的图像数据

image_data = base64.b64decode(response.parts[0].image.data)

# 保存图像

image = Image.open(BytesIO(image_data))

image.save(filename)

print(f"图像已保存为 {filename}")

return image

# 示例:生成一幅传统中国山水画

generate_and_save_image(

"创建一幅传统中国水墨山水画,有高山、流水、小船和远处的村庄,风格优雅细腻。",

"chinese_landscape.png",

resolution="1024x1024",

temperature=0.3

)

# 示例:生成一幅未来科技城市插画

generate_and_save_image(

"创建一幅未来主义科技城市的插画,有飞行汽车、悬浮建筑和全息广告,色彩鲜明,科技感强。",

"future_city.png",

resolution="1024x1024",

temperature=0.7

)使用思考链功能的高级示例

以下是一个更完整的思考链功能应用示例,适用于教育应用场景:

import google.generativeai as genai

import json

# laozhang.ai中转API调用

genai.configure(

api_key="您的LAOZHANG_API_KEY",

api_base="https://api.laozhang.ai"

)

# 创建模型实例

model = genai.GenerativeModel("gemini-2.0-flash-experimental")

# 自定义思考提示

THINKING_PROMPTS = [

"我需要解析这个问题的关键点和已知条件。",

"确定解决这个问题需要用到的数学原理或概念。",

"逐步规划解题思路和计算过程。",

"检查我的解题过程是否正确,结果是否合理。",

"总结最终答案并确保回答了原问题。"

]

def solve_math_problem(problem):

response = model.generate_content(

problem,

generation_config={

"temperature": 0.2,

"thinking": True,

"thinking_prompts": THINKING_PROMPTS,

"max_output_tokens": 1000

}

)

# 提取思考过程

thinking_steps = response.thinking

# 格式化输出

print("📝 问题:\n", problem)

print("\n🧠 思考过程:")

for i, step in enumerate(thinking_steps, 1):

print(f"\n步骤 {i}:\n{step}")

print("\n✅ 最终答案:\n", response.text)

return {

"problem": problem,

"thinking_steps": thinking_steps,

"answer": response.text

}

# 示例:解决一个数学问题

result = solve_math_problem("""

一个圆形游泳池的周长增加了20%,请问它的面积增加了多少百分比?

请详细解释解题过程和数学原理。

""")

# 保存结果(可选)

with open("math_solution.json", "w", encoding="utf-8") as f:

json.dump(result, f, ensure_ascii=False, indent=2)提示:在实际应用中,请确保妥善处理API密钥,避免将其直接嵌入代码或上传到版本控制系统。建议使用环境变量或专门的密钥管理服务来存储和访问API密钥。

常见问题与故障排除

在使用Gemini 2.0 Flash Experimental API的过程中,您可能会遇到各种问题。本章总结了最常见的问题及其解决方案。

API连接问题

| 问题现象 | 解决方案 |

|---|---|

| 连接超时 |

|

| 403 Forbidden错误 |

|

| 429 Too Many Requests |

|

代码集成问题

问题:安装SDK时出现依赖冲突

这通常是由于环境中已存在的包与SDK依赖不兼容造成的。尝试以下解决方案:

- 创建专用的虚拟环境:

python -m venv gemini_env - 激活环境并安装SDK:

source gemini_env/bin/activate(Linux/macOS)或gemini_env\Scripts\activate(Windows) - 如果问题仍然存在,尝试指定版本:

pip install google-generativeai==0.3.1(替换为兼容版本号)

问题:图像生成返回空结果或错误

图像生成功能的常见问题:

- 确保正确指定

output_type="image"参数 - 检查prompt是否违反内容政策(敏感或不适内容会被拒绝)

- 验证分辨率参数格式是否正确(如”1024×1024″,注意是小写的x)

- 如果通过laozhang.ai调用,确保使用最新版本的接口

问题:思考链功能未返回预期结果

如果思考链功能未返回详细的推理过程,请尝试:

- 确保设置了

thinking=True参数 - 尝试提供自定义

thinking_prompts以引导推理过程 - 检查API版本和SDK版本是否支持思考链功能

- 使用更明确的问题描述,例如”请一步步解释如何解决…”

计费与账户问题

常见计费问题解答:

- 为什么我的账单比预期高? – 检查是否忽略了输入token的计费,图像生成次数过多,或未设置

max_output_tokens导致生成内容过长。 - 免费额度用完后会自动扣费吗? – 对于Google官方API,是的;对于laozhang.ai服务,需要手动充值,不会自动扣费。

- 如何监控API使用量? – 通过Google Cloud Console或laozhang.ai控制台可以查看使用统计。

- 如何估算项目成本? – 估算平均输入/输出token数量,乘以单价和预期请求次数。laozhang.ai提供成本计算器。

- 如何获取发票? – Google需要通过Cloud Billing申请;laozhang.ai支持在账户页面直接申请发票。

进阶优化建议

为了获得最佳性能和降低成本,可以考虑以下优化策略:

- 实现请求缓存 – 对于常见问题,缓存响应可以大幅减少API调用次数

- 批量处理请求 – 当可能时,将多个小请求合并为一个大请求

- 设置请求重试机制 – 使用指数退避策略自动重试失败的请求

- 监控和分析 – 实现详细的使用日志和分析,找出优化机会

- 前端优化 – 在用户界面添加输入长度提示,避免用户发送过长内容

# 实现简单的结果缓存示例

import hashlib

import json

import os

import google.generativeai as genai

# 简单的磁盘缓存实现

class SimpleCache:

def __init__(self, cache_dir="./cache"):

self.cache_dir = cache_dir

os.makedirs(cache_dir, exist_ok=True)

def _get_cache_key(self, content, params):

# 创建一个唯一的缓存键

key_data = {

"content": content,

"params": params

}

key_str = json.dumps(key_data, sort_keys=True)

return hashlib.md5(key_str.encode()).hexdigest()

def get(self, content, params):

key = self._get_cache_key(content, params)

cache_file = os.path.join(self.cache_dir, key + ".json")

if os.path.exists(cache_file):

with open(cache_file, "r", encoding="utf-8") as f:

print("命中缓存!")

return json.load(f)

return None

def set(self, content, params, result):

key = self._get_cache_key(content, params)

cache_file = os.path.join(self.cache_dir, key + ".json")

with open(cache_file, "w", encoding="utf-8") as f:

json.dump(result, f, ensure_ascii=False)

# 初始化缓存和API

cache = SimpleCache()

genai.configure(api_key="YOUR_API_KEY", api_base="https://api.laozhang.ai")

model = genai.GenerativeModel("gemini-2.0-flash-experimental")

# 带缓存的API调用函数

def generate_with_cache(prompt, **params):

# 检查缓存

cached_result = cache.get(prompt, params)

if cached_result:

return cached_result

# 调用API

response = model.generate_content(prompt, generation_config=params)

# 将结果存入缓存

result = {"text": response.text}

if params.get("thinking"):

result["thinking"] = response.thinking

cache.set(prompt, params, result)

return result

# 使用示例

result = generate_with_cache(

"解释量子计算的基本原理",

temperature=0.2,

max_output_tokens=500

)通过实施这些优化策略和故障排除方法,您可以更有效地利用Gemini 2.0 Flash Experimental API,提高应用的稳定性,同时控制成本。