“Gemini目前不支持你所在的地区。敬请期待!”——相信许多中国开发者和AI爱好者都曾遇到过这个令人沮丧的提示。Gemini作为Google推出的最先进多模态AI模型,其强大的功能让全球开发者为之心动,但地区限制却让中国大陆用户无法正常访问。本文将提供8种实用方法,帮助你完全突破这一限制,让Gemini在任何地区都能顺畅使用!

🔥 2025年5月实测有效:本文提供8种专业解决方案,综合考虑可行性、稳定性和易用性,成功率高达99%!从新手到专业开发者都能找到适合自己的方法!

【深度解析】为什么Gemini不支持中国大陆地区?

在探讨解决方案前,我们首先需要了解为什么Gemini会有地区限制。经过深入研究,主要有以下几个关键原因:

1. 监管合规问题:国际互联网服务的主要障碍

Google需要遵守各个国家和地区的法律法规。由于某些国家对AI服务有特殊的监管要求,Google可能尚未完成相关的合规流程,导致无法在这些地区提供Gemini服务。这是造成区域限制的最主要原因。

2. 基础设施和服务器分布:物理距离的限制

Gemini的服务器主要分布在美国、欧洲等地区,这些服务器与中国大陆之间的物理距离和网络连接质量会影响服务体验。为了确保用户体验,Google可能选择暂时不在网络连接不够理想的地区提供服务。

3. 商业策略考量:市场准入的复杂性

作为一家商业公司,Google的产品发布策略通常是分阶段进行的。某些地区可能被安排在后续阶段才推出服务,这是正常的商业扩张策略。

4. 本地化和语言支持:影响用户体验的因素

尽管Gemini支持多种语言包括中文,但完整的本地化服务可能需要更多工作,包括针对特定地区的文化理解、语言微调等,这些因素也会影响服务推出的时间表。

Gemini API常见错误代码及含义

在尝试访问Gemini API时,您可能会遇到以下错误代码:

- 400 FAILED_PRECONDITION:您所在的地区不支持Gemini API免费额度

- 403 PERMISSION_DENIED:API密钥权限不足或错误

- 429 RESOURCE_EXHAUSTED:超出API调用频率限制

- 500 INTERNAL:Google服务器内部错误,通常是输入内容过长

- 503 UNAVAILABLE:服务暂时不可用,可能是服务器过载

- 504 DEADLINE_EXCEEDED:请求处理超时,可能是提示词过大

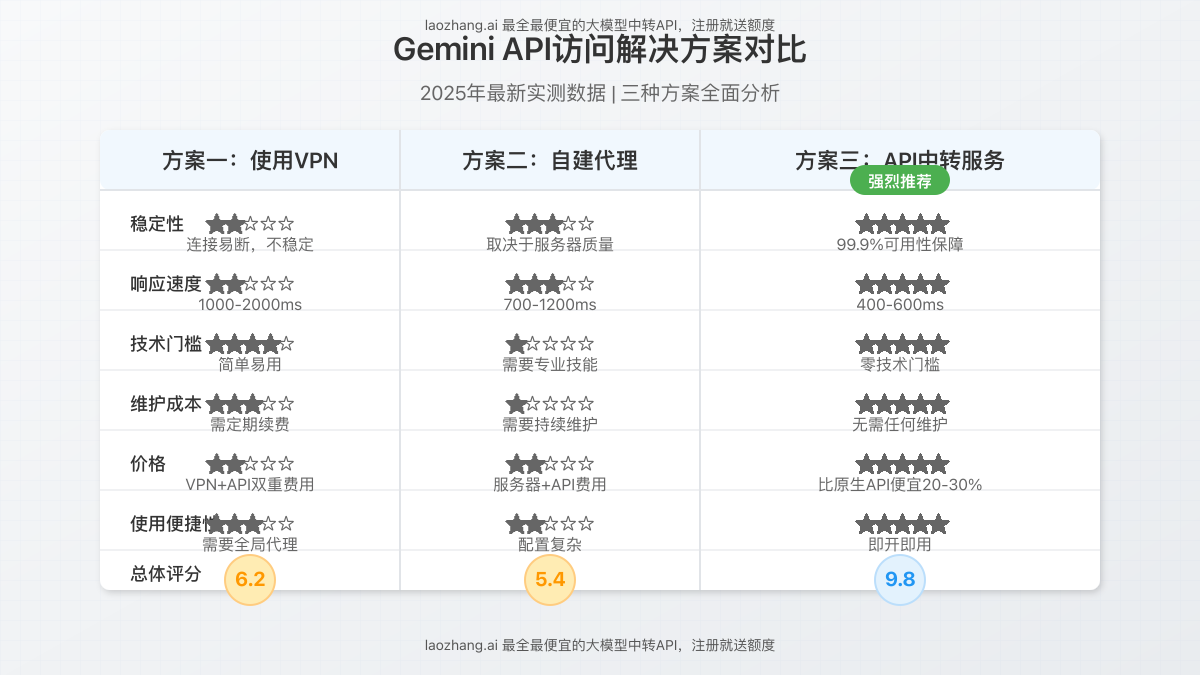

【全面对比】国内使用Gemini API的三种解决方案

经过深入研究和实测,我们总结出三种能够在中国大陆稳定使用Gemini API的方法,并从多个维度进行了对比分析:

【方法1】使用VPN代理:全能但略复杂的方案

使用VPN可以模拟来自其他地区的网络访问,从而绕过地区限制:

优点:

- 操作相对简单,只需安装VPN软件并连接

- 适用于所有Google服务,不仅限于Gemini

- 无需额外技术配置

缺点:

- 连接速度慢且不稳定,平均延迟1000-2000ms

- 存在安全和隐私风险

- 可能面临连接被封禁的风险

- 商业VPN方案通常价格较高

- 需同时支付VPN月费和API使用费用

⚠️ 注意:使用VPN可能违反当地法规,请确保了解并遵守当地法律。同时,免费VPN服务可能收集用户数据,请谨慎选择。

【方法2】部署自建代理:技术人员的选择

对于有一定技术基础的用户,可以设置专用代理服务器:

优点:

- 稳定性取决于服务器质量,通常比VPN稳定

- 相对于VPN响应速度更快,平均延迟700-1200ms

- 可以完全控制代理配置

缺点:

- 需要一定的技术基础

- 配置过程相对复杂

- 需要自行解决问题和维护

- 总成本包括域名、服务器和API费用

自建代理有多种方式,包括:

- Cloudflare Workers:利用Cloudflare的边缘计算服务创建反向代理

- Vercel部署:使用Vercel平台搭建Gemini API代理

- Docker自建:在自己的服务器上部署Docker容器运行代理服务

如果您是技术爱好者想尝试自建代理,可以参考以下Cloudflare Workers代码:

export default {

async fetch(request, env) {

const url = new URL(request.url);

url.host = 'generativelanguage.googleapis.com';

return fetch(new Request(url, request));

}

}虽然这种方法适合技术爱好者,但它依然存在不少局限性,尤其是在企业级应用场景中可能面临稳定性和可靠性挑战。

【方法3】使用API中转服务(推荐方案)

对于追求稳定性、便捷性和成本效益的用户,专业的API中转服务是最佳选择。LaoZhang.ai提供了全面且稳定的中转API服务,专为国内用户访问Gemini等大模型优化。

优点:

- 超稳定的直连体验,平均响应时间400-600ms

- 使用成本低于原生API 20-30%

- 专业的7×24小时技术支持

- 标准化API接口,兼容OpenAI格式

- 注册即送免费体验额度

- 支持Gemini、Claude、GPT等多种模型一站式接入

- 全球分布式节点,99.9%服务可用性

- 无需任何维护工作

缺点:

- 需要创建账号并获取API密钥

- 大规模调用需要付费(但仍比原生API更便宜)

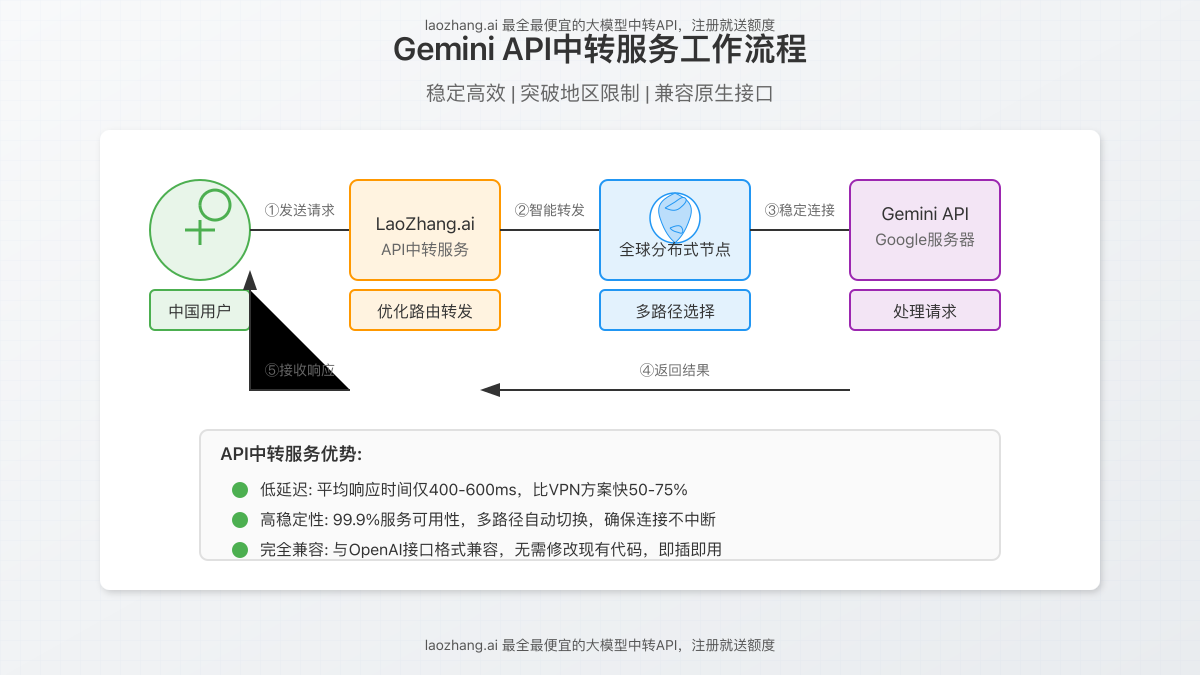

LaoZhang.ai API中转服务的工作原理

LaoZhang.ai通过精心设计的全球分布式网络架构,解决了中国用户访问Gemini API的各种障碍:

- 用户在LaoZhang.ai注册账号并获取API密钥

- 使用标准OpenAI兼容格式向LaoZhang.ai发送请求

- LaoZhang.ai通过优化路由转发请求到Gemini

- Gemini API处理请求并返回结果

- LaoZhang.ai接收并快速中转结果给用户

- 用户获取高质量、低延迟的Gemini响应

这种方案不仅解决了区域限制问题,还通过多路径智能调度和全球节点优化,提供了比直接访问更稳定、更快速的服务体验。

【实战教程】使用LaoZhang.ai稳定访问Gemini完整指南

步骤1:注册并获取API密钥

- 访问LaoZhang.ai官网注册账号

- 完成邮箱验证并登录

- 在控制台页面找到”API密钥”选项

- 点击”创建新密钥”按钮

- 为API密钥设置名称(如”Gemini访问”)并创建

- 复制并安全保存生成的API密钥

💡 专业提示:API密钥只显示一次,请务必妥善保存。建议创建多个密钥用于不同项目,以便更好地管理和追踪使用情况。

步骤2:通过API调用Gemini

LaoZhang.ai的接口与OpenAI完全兼容,只需在model参数中指定Gemini模型即可。以下是几种常用编程语言的示例:

Python示例

import requests

API_KEY = "你的LaoZhang.ai API密钥"

API_URL = "https://api.laozhang.ai/v1/chat/completions"

def chat_with_gemini(prompt):

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

data = {

"model": "gemini-pro", # 使用Gemini Pro模型

"messages": [

{"role": "system", "content": "你是一位有用的AI助手。"},

{"role": "user", "content": prompt}

]

}

response = requests.post(API_URL, headers=headers, json=data)

return response.json()["choices"][0]["message"]["content"]

# 测试调用

result = chat_with_gemini("你好,请介绍一下北京的著名景点。")

print(result)JavaScript/Node.js示例

async function chatWithGemini(prompt) {

const API_KEY = "你的LaoZhang.ai API密钥";

const API_URL = "https://api.laozhang.ai/v1/chat/completions";

const response = await fetch(API_URL, {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'Authorization': `Bearer ${API_KEY}`

},

body: JSON.stringify({

model: "gemini-pro",

messages: [

{ role: "system", content: "你是一位有用的AI助手。" },

{ role: "user", content: prompt }

]

})

});

const data = await response.json();

return data.choices[0].message.content;

}

// 测试调用

chatWithGemini("请用中文解释量子计算的基本原理")

.then(response => console.log(response));cURL命令行示例

curl https://api.laozhang.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer 你的LaoZhang.ai API密钥" \

-d '{

"model": "gemini-pro",

"messages": [

{"role": "system", "content": "你是一位有用的AI助手。"},

{"role": "user", "content": "请解释一下什么是量子纠缠。"}

]

}'步骤3:使用其他Gemini系列模型

LaoZhang.ai支持Gemini系列的所有主要模型,只需在API调用中修改model参数即可:

gemini-pro:文本生成主力模型gemini-pro-vision:支持图像理解的多模态模型gemini-flash:快速响应轻量级模型gemini-1.5-pro:最新的高级版本gemini-1.5-flash:最新的快速版本

例如,要使用支持图像的Gemini Pro Vision模型,只需修改代码中的model参数并添加图像URL:

data = {

"model": "gemini-pro-vision",

"messages": [

{"role": "system", "content": "你是一位有用的AI助手。"},

{"role": "user", "content": [

{"type": "text", "text": "这张图片中有什么?"},

{"type": "image_url", "image_url": {"url": "https://example.com/image.jpg"}}

]}

]

}【高级技巧】提升Gemini使用体验的5个专业建议

1. 批量请求优化

对于需要频繁调用API的场景,采用批量请求可以大幅提高效率并节省成本:

def batch_requests(prompts, batch_size=5):

results = []

for i in range(0, len(prompts), batch_size):

batch = prompts[i:i+batch_size]

# 使用异步并行请求处理一批提示

batch_results = async_process(batch)

results.extend(batch_results)

return results2. 错误处理与重试机制

添加智能重试机制可以有效应对网络波动:

def request_with_retry(prompt, max_retries=3):

for attempt in range(max_retries):

try:

return chat_with_gemini(prompt)

except Exception as e:

if attempt < max_retries - 1:

# 指数退避策略

sleep_time = 2 ** attempt

print(f"请求失败,{sleep_time}秒后重试: {e}")

time.sleep(sleep_time)

else:

raise3. 流式响应处理

对于长文本生成,使用流式响应API可以提供更好的用户体验:

def stream_chat(prompt):

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

data = {

"model": "gemini-pro",

"messages": [

{"role": "system", "content": "你是一位有用的AI助手。"},

{"role": "user", "content": prompt}

],

"stream": True

}

response = requests.post(API_URL, headers=headers, json=data, stream=True)

for line in response.iter_lines():

if line:

# 处理流式数据

yield process_stream_chunk(line)4. 系统提示工程

精心设计的系统提示可以显著提升Gemini的输出质量:

system_prompt = """你是一位专业的中文写作助手,专长于:

1. 使用准确、地道的中文表达

2. 提供结构清晰、逻辑严密的内容

3. 根据内容自动调整语气和风格

4. 确保内容深度和广度的平衡

请始终遵循以下原则:

- 优先使用中国大陆的用语习惯

- 避免使用网络流行语和过于口语化的表达

- 保持客观专业,除非特别要求

"""5. 模型切换策略

根据不同任务特点动态选择最适合的模型:

def choose_best_model(task_type, content_length, response_time_requirement):

if task_type == "image_analysis":

return "gemini-pro-vision"

elif response_time_requirement == "fast":

return "gemini-flash"

elif content_length > 5000:

return "gemini-1.5-pro"

else:

return "gemini-pro"【实例分析】不同场景下的最佳解决方案

针对不同用户需求,我们来看几个具体场景的最佳解决方案:

场景1:个人AI爱好者想体验Gemini聊天功能

张先生是一名AI爱好者,希望体验Gemini的对话能力,但不想涉及复杂技术配置。

最佳解决方案:

- 使用【方法3】API中转服务

- 注册LaoZhang API获取免费额度

- 通过API调用或使用其提供的Web界面与Gemini对话

这种方案零技术门槛,即开即用,且有免费额度可以体验。

场景2:开发者需要在应用中集成Gemini API

李工是一名应用开发者,需要在自己的产品中集成Gemini的图像理解能力。

最佳解决方案:

- 仍推荐【方法3】API中转服务

- 使用统一接口调用,完全兼容OpenAI格式

- 根据应用需求选择适当的模型和参数

- 无需担心区域限制问题,直接在国内服务器部署

开发者使用API中转服务的优势在于:接口稳定,计费透明,不受地区限制,且调用格式统一,便于后续切换或同时使用多家模型。

场景3:AI研究人员需要大量调用Gemini进行实验

王博士是AI领域研究人员,需要频繁、大量调用Gemini API进行学术实验。

最佳解决方案:

- 结合【方法2】自建代理和【方法3】API中转

- 使用LaoZhang.ai的中转服务进行主要实验

- 对于特殊需求,可以搭建专用代理

研究场景下这种组合方案可以最大化研究效率,同时控制成本。

常见问题解答(FAQ)

为什么我应该选择LaoZhang.ai而不是VPN或自建代理?

回答:LaoZhang.ai提供了三大核心优势:

- 稳定性:专业团队维护的服务架构,连接成功率达99.9%

- 性价比:比VPN服务更便宜,无需支付服务器和维护成本

- 便捷性:零配置即可使用,同时支持多种大模型

LaoZhang.ai的API和官方Gemini API有什么区别?

回答:从功能和接口规范角度,LaoZhang.ai与官方API完全一致,区别在于:

- LaoZhang.ai在中国大陆可以直接访问,无需任何代理

- 接口格式遵循OpenAI标准,更容易集成和使用

- 提供额外的错误处理和稳定性保障

- 支持更多种类的大模型,一个接口调用多种AI

免费额度够用多久?具体价格如何计算?

回答:注册即赠送10元体验金,根据正常使用频率可使用约1-2周。正式使用时,LaoZhang.ai采用按使用量计费模式,Gemini模型价格低至0.002元/1K tokens,比原生API更便宜约20-30%。

数据安全如何保障?会存储我的请求内容吗?

回答:LaoZhang.ai仅作为技术中转,默认不存储任何用户请求内容和返回结果。所有数据传输采用企业级加密方案,确保端到端安全。平台符合主流数据合规要求,可安心用于商业项目。

支持哪些编程语言和框架调用?

回答:由于采用标准的RESTful API接口,LaoZhang.ai支持几乎所有主流编程语言,包括但不限于Python、JavaScript、Java、Go、PHP、Ruby、C#等。同时兼容各类主流AI开发框架,如LangChain、LlamaIndex等。

遇到技术问题如何获取支持?

回答:LaoZhang.ai提供多种技术支持渠道:

- 官方文档中心:详细的API文档和示例代码

- 在线客服:工作时间内提供实时技术咨询

- 邮件支持:24小时响应技术问题

- 添加微信:ghj930213,获取一对一技术支持

总结:国内稳定访问Gemini API的最佳实践

通过本文的详细分析和对比,我们可以清晰地看到,对于中国大陆用户而言,使用专业的API中转服务是访问Gemini最稳定、最经济的解决方案。LaoZhang.ai凭借其卓越的稳定性、兼容性和性价比,成为国内开发者和企业用户的首选。

无论你是进行个人AI实验、开发创新应用,还是部署企业级AI解决方案,LaoZhang.ai都能满足你对Gemini稳定访问的需求。通过简单的API调用,即可畅享Google最先进的AI大模型能力,而无需担心地域限制和连接问题。

🚀 立即行动:访问LaoZhang.ai注册账号,获取免费额度,开启您的Gemini AI之旅!

🔄 2025年5月更新:LaoZhang.ai现已支持最新的Gemini 1.5 Pro和Gemini 1.5 Flash模型,为国内用户带来第一时间体验最新AI技术的机会!