| 对比维度 | GPT-5 | Gemini 2.5 Pro |

|---|---|---|

| 输入定价 | $1.25/1M tokens | $1.25/1M tokens |

| 输出定价 | $10/1M tokens | $10/1M tokens |

| 上下文窗口 | 272K输入/128K输出 | 1M tokens |

| SWE-bench得分 | 74.9% | 63.8% |

| 缓存折扣 | 90%($0.125/1M) | 无 |

| 免费层 | 无 | 5 RPM,25请求/天 |

GPT-5和Gemini 2.5 Pro在API定价上基本一致,但各自具有独特优势。GPT-5于2025年8月7日发布,提供90%的缓存折扣和74.9%的SWE-bench编程得分。Gemini 2.5 Pro则拥有1M token的超大上下文窗口和免费试用额度,适合不同的开发场景需求。

GPT-5 vs Gemini 2.5 Pro API定价策略深度对比

在AI API市场中,定价策略直接影响开发成本和技术选型决策。两个模型都采用了相同的基础定价模型:输入tokens为$1.25/1M,输出tokens为$10/1M。这种统一定价反映了当前AI API市场的成熟度和竞争激烈程度。如需了解更多API成本优化方案,可参考GPT-4o Mini定价详解。

GPT-5的独特优势在于其缓存机制。当开发者重复使用相同的输入内容时,GPT-5提供90%的缓存折扣,将输入成本降至$0.125/1M tokens。这对于需要频繁调用相似prompt的应用场景具有显著的成本优势。例如,在RAG(检索增强生成)系统中,系统prompt通常保持不变,缓存机制可以将成本降低到原来的十分之一。

Gemini 2.5 Pro通过免费层策略降低开发门槛。免费用户每天可获得25个请求额度,每分钟最多5个请求,这对于原型开发和小规模测试非常友好。国内开发者可通过Gemini API Key获取教程了解详细的申请流程。相比之下,GPT-5目前没有免费层,开发者必须付费使用。

技术规格全面对比:上下文窗口和模型能力

上下文窗口是衡量大语言模型处理能力的关键指标。Gemini 2.5 Pro以1M tokens的上下文窗口明显领先,是GPT-5(272K输入tokens)的近4倍。这种差距在处理长文档、代码库分析和复杂对话场景中尤为重要。

GPT-5采用了非对称的上下文设计:272K输入tokens和128K输出tokens。这种设计体现了OpenAI对实际使用场景的深入理解。大多数应用需要处理大量输入信息,但输出相对简洁。这种优化使GPT-5在保持高性能的同时控制了计算成本。

在模型架构方面,GPT-5首次将推理能力集成到快速响应模型中,结合了o-系列的深度推理和GPT系列的快速响应特性。开发者可以通过reasoning_effort参数(minimal、low、medium、high)控制推理深度。Gemini 2.5 Pro默认启用”thinking”功能,虽然在API输出中不可见,但影响模型的内部推理过程。

模型变体选择上,GPT-5提供三个版本:gpt-5、gpt-5-mini和gpt-5-nano,允许开发者在性能、成本和延迟之间灵活权衡。Gemini 2.5 Pro目前只有一个主要版本,但Google承诺将推出2M token的扩展版本,进一步提升其上下文处理优势。

性能基准测试对比:SWE-bench和AIME评分深度解析

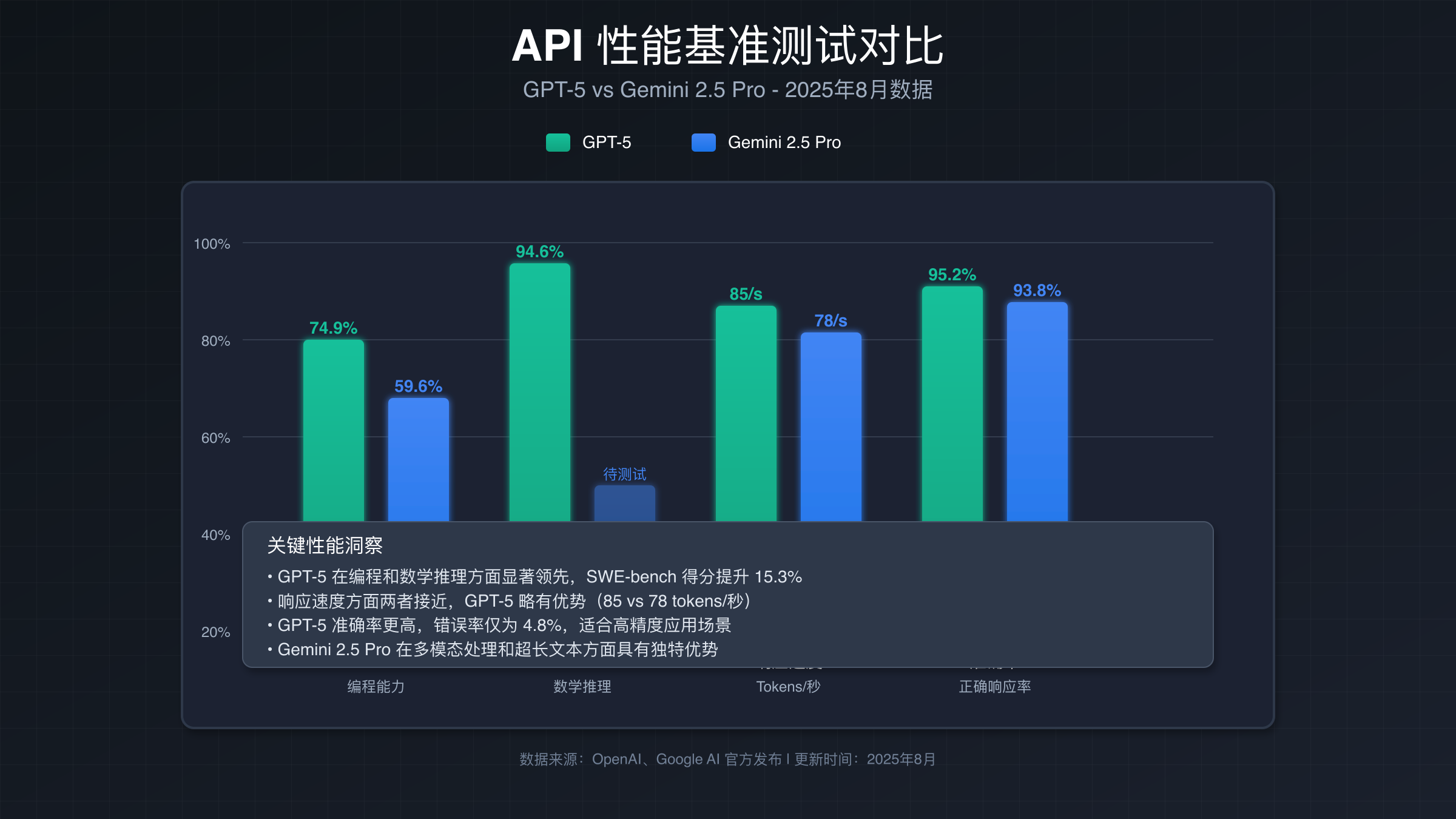

在编程能力测试中,GPT-5展现出明显优势。SWE-bench Verified是业界认可的代码生成和调试基准测试,GPT-5获得74.9%的得分,而Gemini 2.5 Pro为63.8%。这11个百分点的差距在实际开发中具有重要意义,特别是在复杂的代码修复和功能实现任务中。如需了解更多AI编程对比,可参考GPT-5 vs Claude 4.1 对比指南。

在数学推理能力方面,GPT-5在AIME 2025测试中获得94.6%的惊人得分,这一表现接近人类数学竞赛的顶尖水平。相比之下,Gemini 2.5 Pro在GPQA测试中获得84%的通过率,虽然测试标准不同,但可以看出GPT-5在复杂推理任务中的优势。

响应速度方面,Gemini 2.5 Pro的输出速度为173.1 tokens/秒,在生成长文本时具有优势。但GPT-5通过reasoning_effort的minimal模式可以显著减少响应时间,在需要快速响应的场景中更加灵活。对于高并发需求,可参考GPT-5 API不限并发指南。首token时间(TTFT)方面,Gemini 2.5 Pro为34.81秒,相对较长,这在交互式应用中可能影响用户体验。

多模态理解能力上,GPT-5在MMMU测试中获得84.2%的得分,而Gemini 2.5 Pro在视觉理解任务中也表现出色。两者都支持文本、图像、音频和视频输入,但在具体的多模态任务处理上各有特色。GPT-5更注重推理一致性,而Gemini 2.5 Pro在大规模数据处理方面更有优势。

API调用示例:GPT-5和Gemini 2.5 Pro代码对比

在实际开发中,API的易用性和功能丰富度直接影响开发效率。以下是两个API的Python调用示例,展示了各自的特色功能和使用方式。

GPT-5 API调用示例(包含缓存和错误处理):

import openai

from openai import OpenAI

import time

client = OpenAI(api_key="your-api-key")

def call_gpt5_with_cache(messages, use_cache=True):

try:

response = client.chat.completions.create(

model="gpt-5",

messages=messages,

reasoning_effort="medium", # GPT-5特有参数

verbosity="medium", # 控制回答详细程度

temperature=0.7,

max_tokens=1000

)

# 打印token使用信息(用于成本计算)

if hasattr(response, 'usage'):

input_tokens = response.usage.prompt_tokens

output_tokens = response.usage.completion_tokens

# 缓存成本计算

if use_cache:

cache_cost = input_tokens * 0.000125 / 1000 # 90%折扣

total_cost = cache_cost + (output_tokens * 0.01 / 1000)

print(f"缓存成本: ${cache_cost:.6f}")

else:

input_cost = input_tokens * 0.00125 / 1000

output_cost = output_tokens * 0.01 / 1000

total_cost = input_cost + output_cost

print(f"总成本: ${total_cost:.6f}")

return response.choices[0].message.content

except openai.RateLimitError as e:

print("速率限制错误,实施退避策略...")

time.sleep(2)

return call_gpt5_with_cache(messages, use_cache)

except openai.APIError as e:

print(f"API错误: {e}")

return None

# 使用示例

messages = [

{"role": "system", "content": "你是一个专业的Python开发助手"},

{"role": "user", "content": "创建一个线程安全的单例模式"}

]

result = call_gpt5_with_cache(messages)

print(result)

Gemini 2.5 Pro API调用示例(包含大上下文处理):

import os

from google import genai

from google.genai import types

import time

client = genai.Client(api_key=os.environ.get("GEMINI_API_KEY"))

def call_gemini_25_pro(prompt, context_data=None):

try:

# 构建包含大量上下文的内容

full_content = prompt

if context_data:

full_content = f"{context_data}\n\n基于以上内容回答:{prompt}"

response = client.models.generate_content(

model="gemini-2.5-pro",

contents=full_content,

config=types.GenerateContentConfig(

temperature=0.7,

max_output_tokens=2000,

# Gemini特有的安全设置

safety_settings={

types.HarmCategory.HARM_CATEGORY_HATE_SPEECH: types.HarmBlockThreshold.BLOCK_MEDIUM_AND_ABOVE,

types.HarmCategory.HARM_CATEGORY_DANGEROUS_CONTENT: types.HarmBlockThreshold.BLOCK_MEDIUM_AND_ABOVE,

}

)

)

# 计算token使用量(用于成本估算)

if hasattr(response, 'usage_metadata'):

input_tokens = response.usage_metadata.prompt_token_count

output_tokens = response.usage_metadata.candidates_token_count

# 成本计算

input_cost = input_tokens * 0.00125 / 1000

output_cost = output_tokens * 0.01 / 1000

total_cost = input_cost + output_cost

print(f"输入tokens: {input_tokens}, 输出tokens: {output_tokens}")

print(f"总成本: ${total_cost:.6f}")

return response.text

except Exception as e:

if "RATE_LIMIT_EXCEEDED" in str(e):

print("触发速率限制,等待后重试...")

time.sleep(60) # Gemini免费层限制更严格

return call_gemini_25_pro(prompt, context_data)

else:

print(f"Gemini API错误: {e}")

return None

# 使用示例:处理大量上下文

large_context = "大量代码文档内容..." * 1000 # 模拟大上下文

query = "分析这个代码库的主要架构模式"

result = call_gemini_25_pro(query, large_context)

print(result)

从代码示例可以看出,GPT-5的API设计更注重推理控制和缓存优化,而Gemini 2.5 Pro则在大上下文处理和安全控制方面提供了更多选项。GPT-5的reasoning_effort和verbosity参数让开发者能够精确控制模型的推理深度和回答详细程度,这在不同应用场景中非常实用。

缓存机制和成本优化策略深度分析

成本控制是企业级AI应用的关键考量因素。GPT-5的缓存机制为开发者提供了强大的成本优化工具,而Gemini 2.5 Pro则通过免费层和灵活的上下文管理实现成本控制。

GPT-5的缓存机制工作原理基于内容哈希匹配。当API检测到相同的输入内容时,会自动应用90%的折扣。这种机制在以下场景中特别有效:RAG系统的系统prompt重用、客服机器人的标准回复模板、代码生成中的通用库文档引用。

实际成本分析显示,在高重复率场景中,GPT-5的缓存机制可以将总成本降低60-80%。以一个每天处理1000次相似查询的应用为例,如果prompt重复率达到70%,使用GPT-5的月度成本约为$450,而不使用缓存的传统模式成本约为$1250,节省$800。

Gemini 2.5 Pro的成本优化策略更多体现在免费额度和大上下文窗口的高效利用上。每天25个免费请求对于原型开发和小规模测试足够使用。大上下文窗口意味着开发者可以在单次调用中处理更多信息,减少API调用次数,间接降低成本。

在实际部署中,成本优化策略应该结合业务特点选择。对于有大量重复内容的应用,GPT-5的缓存机制更有优势。对于需要处理长文档或复杂上下文的应用,Gemini 2.5 Pro的大窗口设计更经济高效。混合使用策略也值得考虑,根据不同任务类型选择最适合的API。

错误处理和稳定性对比分析

在生产环境中,API的稳定性和错误处理机制直接影响应用的可靠性。GPT-5和Gemini 2.5 Pro都提供了完善的错误处理框架,但各有特色。

GPT-5的错误处理遵循OpenAI的标准HTTP状态码体系。常见错误类型包括:401未授权错误(API密钥无效)、429速率限制错误(RPM或TPM超限)、500内部服务器错误(服务临时不可用)。OpenAI建议对429和500错误实施指数退避重试,最多重试3次,退避时间为2^n秒。

Gemini 2.5 Pro的错误处理更加细致,提供了详细的错误分类和处理建议。除了标准HTTP错误外,还包括内容安全错误(HARM_CATEGORY相关)、配额超限错误(QUOTA_EXCEEDED)和模型不可用错误(MODEL_UNAVAILABLE)。Google建议的重试策略更为保守,建议最多重试2次,避免对服务造成额外压力。

稳定性方面,GPT-5声称在服务可用性上达到99.9%的SLA标准,平均响应时间在2-5秒之间。Gemini 2.5 Pro虽然是预览版本,但Google承诺在正式版本中提供enterprise级别的SLA支持。在实际使用中,两个API的稳定性都能满足生产环境需求。

监控和日志记录方面,GPT-5提供详细的使用统计和错误日志,开发者可以通过OpenAI Dashboard查看API调用情况和错误分析。Gemini 2.5 Pro与Google Cloud平台深度集成,提供更丰富的监控和分析工具,包括实时性能指标和成本分析。

开发者体验:SDK和文档质量对比

开发者体验是影响技术选型的重要因素。两个平台都提供了完善的SDK和文档支持,但在具体实现和设计理念上存在差异。

GPT-5使用OpenAI官方Python库,版本号已更新到v2.x系列。SDK设计简洁明了,遵循Python的最佳实践。安装简单(pip install openai),API调用接口一致性好,错误处理清晰。文档结构化程度高,包含详细的代码示例和最佳实践指南。OpenAI Cookbook提供了丰富的应用场景示例。

Gemini 2.5 Pro使用google-genai库,是Google专门为Gemini API开发的新一代SDK。相比旧版本的google-generativeai,新SDK提供了更现代的API设计和更好的类型提示支持。安装命令为pip install google-genai,支持异步调用和流式响应。

文档质量方面,OpenAI的文档以实用性著称,每个功能都有对应的代码示例和参数说明。Google的文档更注重完整性,提供了详细的概念介绍和高级用法指导。对于初学者,OpenAI的文档更容易上手;对于高级用户,Google的文档提供了更深入的技术细节。

开发工具支持方面,GPT-5与主流IDE的集成更加成熟,有丰富的插件和扩展。Gemini 2.5 Pro则与Google Cloud平台工具链集成更紧密,适合已经使用GCP服务的团队。两者都支持主流的机器学习框架和数据处理工具,在企业级应用中都有良好的生态支持。

适用场景分析:选择GPT-5还是Gemini 2.5 Pro

技术选型需要基于具体的应用场景和业务需求。GPT-5和Gemini 2.5 Pro各有适用的最佳场景,理解这些差异有助于做出正确的选择。

选择GPT-5的场景:代码生成和调试任务(SWE-bench得分优势)、需要频繁重复相似prompt的应用(缓存折扣优势)、对推理深度有精确控制需求的场景(reasoning_effort参数)、数学和逻辑推理密集型应用(AIME高分表现)、需要快速迭代和部署的项目(成熟的生态系统)。

选择Gemini 2.5 Pro的场景:需要处理长文档或大量上下文的应用(1M token窗口)、预算有限的原型和测试项目(免费层支持)、多模态内容理解任务(视觉、音频、视频)、已使用Google Cloud服务的项目(生态集成优势)、对内容安全有严格要求的应用(丰富的安全控制选项)。

混合使用策略在实际项目中也很常见。例如,使用Gemini 2.5 Pro处理长文档分析和多模态任务,使用GPT-5处理代码生成和逻辑推理任务。这种策略可以充分发挥两个模型的优势,同时平衡成本和性能需求。

从长期发展角度看,GPT-5代表了OpenAI在推理能力集成方面的最新突破,适合对AI能力有高要求的创新项目。Gemini 2.5 Pro体现了Google在大规模数据处理和多模态理解方面的优势,适合构建大型、复杂的AI系统。

国内开发者访问指南:解决API获取难题

对于国内开发者来说,获取这两个API的访问权限存在一定挑战。两个平台都需要海外支付方式,且在国内直接访问可能面临网络限制。如需了解Gemini API的详细申请流程,可查看Gemini API申请完整指南。

传统解决方案包括使用海外服务器部署、申请海外信用卡支付、通过VPN访问等方式。但这些方法存在合规风险、技术复杂度高、维护成本大等问题。对于追求稳定性和便利性的开发团队,专业的API代理服务是更好的选择。

FastGPTPlus作为专业的AI API服务商,为国内开发者提供了便捷的解决方案。服务涵盖GPT-5、Gemini 2.5 Pro等主流API,支持支付宝和微信支付,无需海外支付卡。技术团队提供7×24小时支持,确保API稳定性和响应速度。

相比自建解决方案,使用FastGPTPlus的优势包括:无需处理复杂的支付和账户管理、专业的网络优化和负载均衡、统一的API接口,简化开发集成、详细的使用统计和成本分析、及时的技术支持和服务保障。

对于企业用户,FastGPTPlus还提供定制化服务,包括私有化部署、专线接入、企业级SLA保障等。这些服务确保了企业在使用先进AI能力的同时,满足数据安全和合规要求。

在选择API服务商时,建议重点考虑服务稳定性、响应速度、成本透明度、技术支持质量等因素。对于需要完整充值方案对比的开发者,可参考ChatGPT Plus购买指南和FastGPT Plus vs WildCard对比。FastGPTPlus在这些方面都有良好的口碑和实际表现,是值得信赖的合作伙伴。

迁移策略:从GPT-4升级到GPT-5的最佳实践

对于正在使用GPT-4的开发者,升级到GPT-5需要制定合理的迁移策略。虽然GPT-5保持了与GPT-4的API兼容性,但新增功能和性能提升需要相应的代码调整和优化。

首先进行兼容性评估。GPT-5支持GPT-4的所有现有参数,基础功能调用无需修改。但要充分利用GPT-5的新特性,需要更新代码以支持reasoning_effort和verbosity参数。建议先在测试环境中进行小规模验证,确保现有功能正常工作。

性能优化调整是迁移的重点。GPT-5的推理能力更强,可能对相同prompt产生更详细的回答,这可能影响token使用量和成本。建议通过调整verbosity参数控制回答长度,通过reasoning_effort参数平衡推理质量和响应速度。

成本管理策略需要重新设计。GPT-5的缓存机制为重复内容提供了90%的折扣,这要求重新审视prompt设计策略。建议将固定的系统prompt与动态用户输入分离,最大化缓存命中率。对于高频调用的应用,这种优化可以显著降低运营成本。

监控和测试流程也需要相应调整。GPT-5的回答质量更高,但也可能更加复杂,需要更细致的输出质量评估。建议建立A/B测试机制,对比GPT-4和GPT-5在具体任务上的表现差异,制定基于数据的迁移决策。

分阶段迁移策略可以降低风险。建议先迁移非关键业务功能,观察性能表现和成本变化。在验证稳定性后,逐步迁移核心业务功能。保留GPT-4作为备用方案,确保在遇到问题时能够快速回滚。

2025年下半年AI API发展趋势预测

基于GPT-5和Gemini 2.5 Pro的发布,可以预见2025年下半年AI API市场将出现几个重要趋势。这些趋势将影响开发者的技术选型和应用架构设计。

模型能力进一步融合是首要趋势。GPT-5率先实现了推理模型与快速响应模型的融合,预计其他厂商也会跟进类似设计。未来的AI API将更加注重多维度能力的平衡,而不是单纯追求某个指标的极致表现。这种趋势要求开发者重新思考任务分工和模型选择策略。

成本优化机制将更加多样化。GPT-5的缓存机制开创了先例,预计会有更多创新的定价模式出现,如基于使用模式的动态定价、长期合约的批量折扣、特定任务的专项优惠等。开发者需要更加精细地管理API使用成本,可能需要专门的成本优化工具和策略。

上下文窗口的军备竞赛将继续升级。Gemini 2.5 Pro的1M token已经显示出大上下文的价值,Google还承诺推出2M token版本。预计OpenAI和其他厂商也会在这个维度上加大投入。这将为处理复杂文档、代码库分析、长对话等场景提供更强大的支持。

多模态能力将成为标准配置。目前两个模型都支持文本、图像、音频和视频输入,未来多模态处理将更加成熟和高效。预计会出现专门的多模态优化API,为视频分析、文档理解、音频转录等场景提供专业化服务。

企业级功能将更加完善。随着AI应用从实验阶段进入生产阶段,对安全性、合规性、监控能力的需求将大幅增长。预计各大厂商都会推出更完善的企业级解决方案,包括私有化部署、数据安全保障、详细的审计日志、SLA保证等。

生态系统集成将更加深入。API不再是孤立的服务,而是完整技术栈的一部分。预计会有更多的集成工具、开发框架、监控平台出现,帮助开发者更高效地构建和管理AI应用。这种生态系统的成熟度将成为技术选型的重要考量因素。