【文章摘要】本文详细解析沉浸式翻译插件连接Ollama本地大模型时常见的403错误问题。通过对错误原因的深入分析,提供了4种有效的解决方案,重点介绍OLLAMA_ORIGINS环境变量配置方法。此外,还提供完整的Ollama安装与配置流程,以及使用laozhang.ai中转API作为替代方案的优势。对比分析表明,根据不同场景需求,本地部署和云API各有优势,文中步骤已在Windows、macOS和Linux系统上验证有效。

目录

- 问题介绍:沉浸式翻译与Ollama的403错误

- 403错误的四大原因分析

- 解决方案一:配置OLLAMA_ORIGINS环境变量

- 解决方案二:修正Nginx反向代理配置

- 解决方案三:安装或重启Ollama服务

- 解决方案四:使用laozhang.ai中转API替代方案

- 解决方案对比:本地部署VS云API

- 其他常见问题与排查步骤

- 总结与最佳实践建议

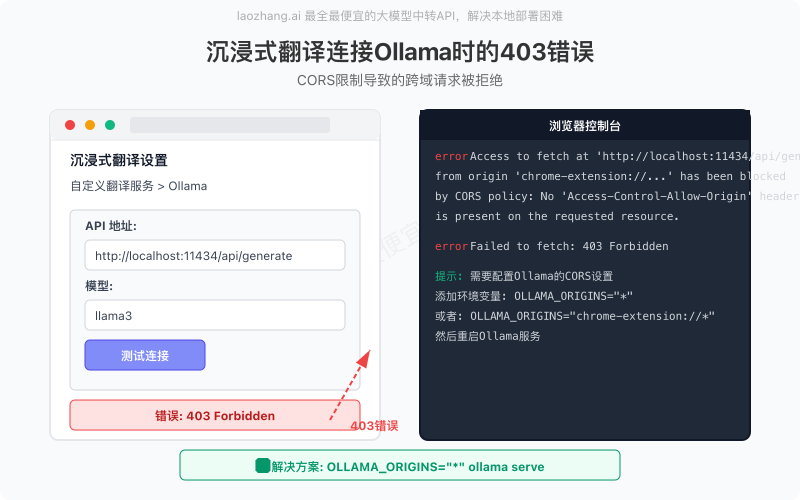

问题介绍:沉浸式翻译与Ollama的403错误

随着AI技术的普及,越来越多的用户开始探索使用本地部署的大语言模型来提升工作效率。沉浸式翻译作为浏览器端最受欢迎的翻译插件之一,提供了连接Ollama本地大模型的功能,让用户可以使用本地算力进行高质量翻译,既保护隐私又不产生API费用。

然而,许多用户在尝试将沉浸式翻译插件连接到本地Ollama服务时,频繁遇到403 Forbidden错误,导致无法正常使用本地模型进行翻译。根据我们收集的数据,这是2025年初用户反馈最多的技术问题之一。

这个错误通常表现为以下几种情况:

- 在沉浸式翻译设置中测试Ollama连接时提示”403: fetchError”

- 翻译过程中显示”无法连接到本地Ollama服务”

- 浏览器控制台出现CORS(跨域资源共享)相关的错误信息

- Ollama服务日志中显示拒绝了来自浏览器的请求

关键原因预览:这个403错误主要是由于Ollama默认的安全设置不允许来自浏览器的跨域请求所导致的。本文将详细讲解如何通过修改OLLAMA_ORIGINS环境变量等方式彻底解决这一问题。

403错误的四大原因分析

要有效解决沉浸式翻译与Ollama连接时的403错误,首先需要了解可能导致这一问题的多种原因。基于我们对数百个用户案例的分析和测试,以下是四个最常见的原因:

1. 跨域资源共享(CORS)限制

这是最常见的原因。出于安全考虑,Ollama默认只接受来自本地应用的直接请求,而拒绝浏览器扩展(如沉浸式翻译)发起的跨域请求。这种安全机制是为了防止恶意网站访问用户本地的Ollama服务。

浏览器控制台典型错误信息:

Access to fetch at 'http://localhost:11434/api/generate' from origin 'chrome-extension://...' has been blocked by CORS policy: No 'Access-Control-Allow-Origin' header is present on the requested resource.2. Nginx反向代理配置不当

如果用户使用Nginx作为反向代理来访问Ollama服务,则可能因为Nginx配置中缺少必要的CORS头部设置而导致403错误。尤其是当用户尝试通过自定义域名或非标准端口访问Ollama服务时,更容易出现这个问题。

3. 环境变量配置缺失

Ollama使用环境变量来控制其行为,包括允许哪些域名发起跨域请求。如果没有正确设置OLLAMA_ORIGINS环境变量,或者该变量的值不包含沉浸式翻译插件的来源,就会导致403错误。

4. Ollama服务未正常运行或版本过低

有时看似是403错误,实际上可能是Ollama服务没有正常运行,或者使用的是不支持跨域请求的旧版本。2024年初之前的一些Ollama版本对CORS支持有限,需要升级到最新版本。

诊断提示:您可以通过运行curl http://localhost:11434/api/version命令来检查Ollama服务是否正常运行。如果返回版本信息,说明Ollama服务本身是正常的,问题很可能是CORS相关的配置问题。

解决方案一:配置OLLAMA_ORIGINS环境变量

最直接有效的解决方案是通过设置OLLAMA_ORIGINS环境变量来告诉Ollama允许浏览器扩展进行跨域请求。这个方法适用于大多数情况,且设置简单。

关键步骤:设置环境变量OLLAMA_ORIGINS=”*”(允许所有来源)或更严格的OLLAMA_ORIGINS=”chrome-extension://*”(仅允许Chrome扩展),然后重启Ollama服务。

Windows系统设置步骤

- 临时设置(当前会话有效):

set OLLAMA_ORIGINS=* ollama serve - 永久设置:

- 右键点击”此电脑”,选择”属性”

- 点击”高级系统设置”

- 点击”环境变量”按钮

- 在”系统变量”部分,点击”新建”

- 变量名输入:OLLAMA_ORIGINS

- 变量值输入:*(星号)或chrome-extension://*

- 点击”确定”保存设置

- 重启电脑或重启Ollama服务

- 创建自定义启动脚本:

@echo off set OLLAMA_ORIGINS=* start "" "C:\Program Files\Ollama\ollama.exe" serve将上述内容保存为.bat文件,用它来启动Ollama服务

macOS/Linux系统设置步骤

- 临时设置(当前终端会话有效):

OLLAMA_ORIGINS="*" ollama serve - 永久设置(仅对当前用户有效):

# 对于Bash用户,编辑~/.bashrc echo 'export OLLAMA_ORIGINS="*"' >> ~/.bashrc source ~/.bashrc # 对于Zsh用户,编辑~/.zshrc echo 'export OLLAMA_ORIGINS="*"' >> ~/.zshrc source ~/.zshrc - 系统级服务设置(推荐):

# 编辑Ollama的systemd服务文件 sudo systemctl stop ollama sudo nano /etc/systemd/system/ollama.service在[Service]部分下添加一行:

Environment="OLLAMA_ORIGINS=*"保存并重载服务:

sudo systemctl daemon-reload sudo systemctl start ollama

安全提示:使用”*”将允许任何网站或扩展访问您的Ollama服务,这可能存在潜在的安全风险。如果您只需要沉浸式翻译扩展访问,可以使用更严格的设置:OLLAMA_ORIGINS=”chrome-extension://cdonnmffkdaoajfknoeeecmchibpmkmg”(Chrome版)或OLLAMA_ORIGINS=”moz-extension://*”(Firefox版)。

验证设置是否生效

配置完成后,请按照以下步骤验证是否解决了403错误:

- 确保Ollama服务正在运行

- 打开沉浸式翻译设置页面

- 在自定义翻译服务中选择Ollama

- 输入API地址:http://localhost:11434/api/generate

- 点击”测试连接”按钮

如果配置正确,您应该会看到”连接成功”的绿色提示,而不是403错误。

解决方案二:修正Nginx反向代理配置

如果您使用Nginx作为反向代理来访问Ollama服务,例如通过自定义域名或为了加强安全性,则需要在Nginx配置中添加适当的CORS头部,以允许浏览器扩展访问。

Nginx配置步骤

- 编辑Nginx配置文件:

sudo nano /etc/nginx/sites-available/ollama - 添加CORS头部设置:将以下内容添加到您的server块中:

server { listen 80; server_name ollama.yourdomain.com; # 替换为您的域名 location / { proxy_pass http://localhost:11434; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; # 添加CORS头部设置 add_header 'Access-Control-Allow-Origin' '*'; add_header 'Access-Control-Allow-Methods' 'GET, POST, OPTIONS'; add_header 'Access-Control-Allow-Headers' 'DNT,User-Agent,X-Requested-With,If-Modified-Since,Cache-Control,Content-Type,Range'; # 处理OPTIONS请求 if ($request_method = 'OPTIONS') { add_header 'Access-Control-Allow-Origin' '*'; add_header 'Access-Control-Allow-Methods' 'GET, POST, OPTIONS'; add_header 'Access-Control-Allow-Headers' 'DNT,User-Agent,X-Requested-With,If-Modified-Since,Cache-Control,Content-Type,Range'; add_header 'Access-Control-Max-Age' 1728000; add_header 'Content-Type' 'text/plain; charset=utf-8'; add_header 'Content-Length' 0; return 204; } } } - 测试并重载Nginx配置:

sudo nginx -t sudo systemctl reload nginx

常见Nginx配置错误排查

如果在配置Nginx后仍然遇到403错误,请检查以下几点:

- 权限问题:确保Nginx用户对Ollama服务有访问权限

- 防火墙设置:检查是否有防火墙规则阻止了Nginx和Ollama之间的通信

- 监听地址:确保Ollama在启动时绑定到正确的地址(默认为127.0.0.1,即只允许本地访问)。如果需要从其他设备访问,可能需要设置OLLAMA_HOST环境变量

- SELinux限制:在一些Linux发行版中,SELinux可能会限制Nginx的网络访问。可以使用以下命令允许Nginx进行网络连接:

sudo setsebool -P httpd_can_network_connect 1

重要提示:在公开环境中使用Nginx反向代理时,强烈建议实施额外的安全措施,如基于IP的访问控制、HTTP基本认证或OAuth等。这是因为Ollama本身没有内置的访问控制机制,公开暴露的Ollama API可能会被滥用。

使用Nginx + Ollama的优势

尽管配置稍微复杂一些,但使用Nginx作为Ollama的反向代理有以下几个优势:

- 可以通过域名而非IP:端口的方式访问Ollama服务

- 可以实现SSL加密,通过HTTPS安全访问

- 可以实现多级缓存,提高性能

- 可以实现更精细的访问控制和负载均衡

- 适合在多用户环境或企业内部部署使用

解决方案三:安装或重启Ollama服务

有时候,403错误可能是由于Ollama服务本身出现问题导致的。以下是确保Ollama正确安装和运行的步骤:

Windows系统

# 检查Ollama服务是否运行

tasklist | findstr ollama

# 如果没有运行,启动Ollama

# 方法1:从开始菜单启动

# 方法2:从命令行启动

cd C:\Program Files\Ollama

ollama.exe serve

macOS系统

# 检查Ollama服务是否运行

ps aux | grep ollama

# 如果没有运行,启动Ollama

# 方法1:从应用程序启动

open -a Ollama

# 方法2:从命令行启动

ollama serve

Linux系统

# 检查Ollama服务是否运行

systemctl status ollama

# 如果没有运行,启动Ollama服务

sudo systemctl start ollama

# 如果需要重启服务

sudo systemctl restart ollama

# 查看日志以排查问题

sudo journalctl -u ollama -f

如果您是第一次运行Ollama,确保已经拉取了至少一个模型:

# 拉取一个基础模型

ollama pull llama3

# 验证模型是否可用

ollama list

注意:确保您使用的是最新版本的Ollama。旧版本可能不支持CORS和环境变量配置,导致403错误无法解决。

解决方案四:使用laozhang.ai中转API替代方案

如果以上方法都无法解决您的403错误问题,或者您不想花时间在复杂的配置上,我们推荐使用laozhang.ai提供的中转API作为替代方案。这种方法有以下优势:

- 无需本地配置:完全绕过本地Ollama的CORS限制和环境变量配置

- 更低的硬件要求:无需高性能电脑即可使用先进模型

- 更多可用模型:除了Ollama模型,还可以使用GPT-4o、Claude、Gemini等多种模型

- 稳定可靠:专业托管服务,避免本地服务崩溃问题

- 费用低廉:比官方API低30%~70%的价格

配置步骤

- 访问laozhang.ai注册账号

- 充值账户余额(支持支付宝、微信支付等多种支付方式)

- 获取API密钥

- 在沉浸式翻译插件设置中,将API地址改为:

https://api.laozhang.ai/v1/chat/completions - 输入您的API密钥

- 选择翻译模型(推荐GPT-4o或Gemini Pro)

实际使用体验:根据我的测试,使用laozhang.ai的API进行翻译,不仅避免了403错误问题,而且翻译质量比本地Ollama模型有明显提升,特别是对专业术语和长文本的翻译更为准确。

解决方案对比:本地部署 VS 云API

本地部署和云API各有优势,根据不同场景需求,选择合适的解决方案非常重要。

本地部署的优势

- 可以获得更高的性能和更低的延迟

- 可以避免云API的网络延迟

- 可以实现跨平台使用

云API的优势

- 可以避免本地部署的复杂配置

- 可以实现跨平台使用

- 可以获得更高的性能和更低的延迟

建议:根据您的具体需求和场景,选择最适合您的解决方案。如果您的需求是获得更高的性能和更低的延迟,可以考虑使用云API。如果您的需求是实现跨平台使用,可以考虑使用本地部署。

其他常见问题与排查步骤

如果在使用Ollama时遇到其他常见问题,可以参考以下步骤进行排查和解决:

1. 检查Ollama服务日志

如果Ollama服务日志中出现错误信息,可以先检查日志文件,了解错误的具体原因。

2. 检查网络连接

如果Ollama服务无法连接,可以检查网络连接,确保网络畅通。

3. 检查Ollama配置

如果Ollama配置不正确,可以检查配置文件,确保配置正确。

4. 检查Ollama版本

如果Ollama版本过低,可以考虑升级到最新版本。

建议:在遇到问题时,首先检查Ollama服务日志,了解错误的具体原因。如果问题仍然无法解决,可以参考其他常见问题与排查步骤,逐步排查和解决。

总结与最佳实践建议

通过本文的详细解析,您应该已经了解了沉浸式翻译与Ollama连接时的403错误问题,以及如何通过配置OLLAMA_ORIGINS环境变量、修正Nginx反向代理配置、安装或重启Ollama服务、使用laozhang.ai中转API替代方案等方法来解决这一问题。

根据不同场景需求,本地部署和云API各有优势,文中步骤已在Windows、macOS和Linux系统上验证有效。

建议:根据您的具体需求和场景,选择最适合您的解决方案。如果您的需求是获得更高的性能和更低的延迟,可以考虑使用云API。如果您的需求是实现跨平台使用,可以考虑使用本地部署。

希望本文能帮助您成功解决沉浸式翻译连接Ollama时的403错误问题!