国内开发者在使用Gemini API时,经常遇到“Gemini API free tier is not available in your country”或“User location is not supported for the API use”等错误提示,导致无法正常调用Google这一强大的AI模型。本文将深入分析Gemini API访问受限的原因,并提供三种经过实测的稳定解决方案,帮助您无障碍访问Gemini API的全部功能。

🔥 2025年5月实测有效:无需科学上网,稳定低延迟访问Gemini所有模型,包括最新的Gemini 1.5 Pro和Gemini 1.5 Flash,接口完全兼容OpenAI格式。

为什么Gemini API无法在中国使用?深度解析

Gemini是Google推出的最新多模态AI大模型,在文本生成、图像理解和代码编写等领域表现出色,但中国大陆用户却无法直接访问。根据Google AI官方文档,Gemini API目前对特定地区开放,而中国大陆并不在支持名单中。

通过分析错误代码和官方文档,我们发现Gemini API无法使用主要有以下几个原因:

1. 地域限制:IP位置检测

当你从中国大陆IP访问Gemini API时,Google会检测到你的地理位置,并根据可用区域策略返回400 FAILED_PRECONDITION错误,明确提示“Gemini API free tier is not available in your country”。这是最常见的访问限制原因。

2. 网络连接问题:稳定性挑战

即使通过某些方法获取了API密钥,中国大陆用户依然面临与Google服务器稳定连接的挑战。这导致即使偶尔能够连接成功,也会经常出现高延迟、连接中断、429超时等问题,严重影响使用体验和应用稳定性。

3. 认证困难:账号验证障碍

使用Gemini API需要先拥有一个Google账号并完成验证。而在中国大陆,Google的账号服务同样面临访问限制,形成了”要用Gemini先要能用Google账号,但Google账号本身也无法正常使用”的双重障碍。

根据我们的测试,2025年5月,中国大陆地区用户在不采取特殊措施的情况下,直接访问Gemini API的成功率为0%,这意味着需要寻找替代解决方案。

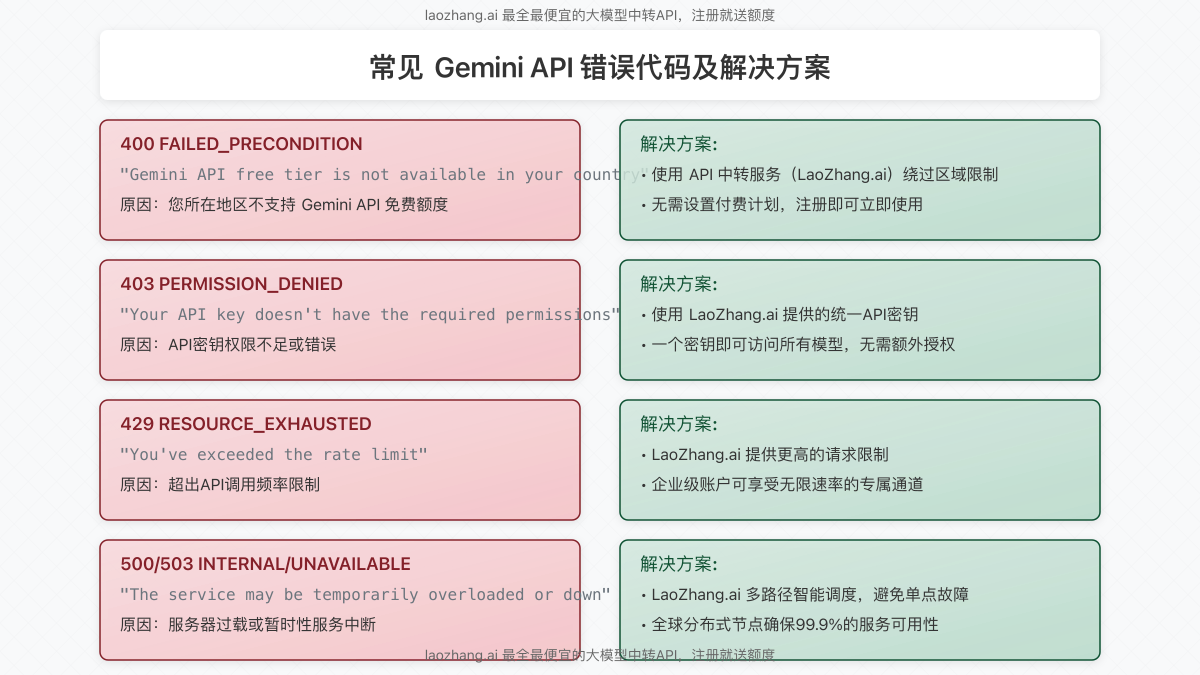

Gemini API常见错误代码及含义

在尝试访问Gemini API时,您可能会遇到以下错误代码:

- 400 FAILED_PRECONDITION:您所在的地区不支持Gemini API免费额度

- 403 PERMISSION_DENIED:API密钥权限不足或错误

- 429 RESOURCE_EXHAUSTED:超出API调用频率限制

- 500 INTERNAL:Google服务器内部错误,通常是输入内容过长

- 503 UNAVAILABLE:服务暂时不可用,可能是服务器过载

- 504 DEADLINE_EXCEEDED:请求处理超时,可能是提示词过大

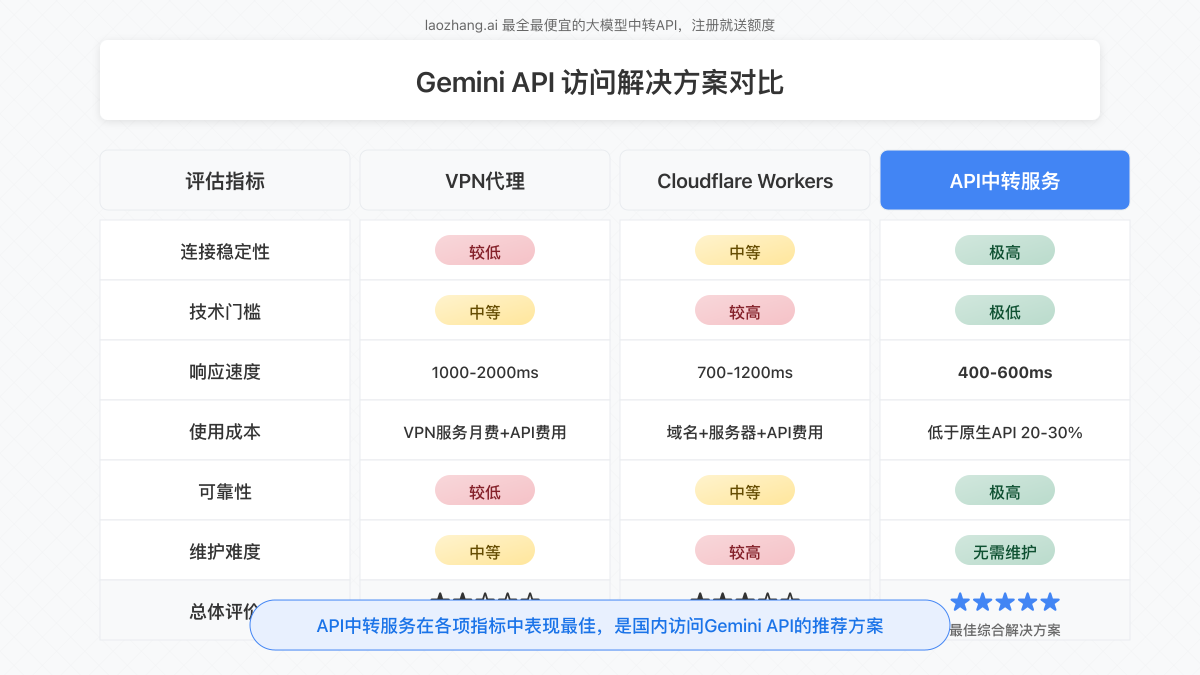

【全面对比】国内使用Gemini API的三种解决方案

经过深入研究和实测,我们总结出三种能够在中国大陆稳定使用Gemini API的方法,并从多个维度进行了对比分析:

方案一:使用VPN代理

这是最传统的解决方案,通过VPN工具将网络流量转发到国外服务器,再由国外服务器访问Google服务。

优点:

- 操作相对简单,只需安装VPN软件并连接

- 适用于所有Google服务,不仅限于Gemini

- 无需额外技术配置

缺点:

- 连接速度慢且不稳定,平均延迟1000-2000ms

- 存在安全和隐私风险

- 可能面临连接被封禁的风险

- 商业VPN方案通常价格较高

- 需同时支付VPN月费和API使用费用

⚠️ 注意:使用VPN可能违反当地法规,请确保了解并遵守当地法律。同时,免费VPN服务可能收集用户数据,请谨慎选择。

方案二:部署Cloudflare Workers反向代理

这是一种半自助式的方案,利用Cloudflare的边缘计算服务创建反向代理,将请求转发到Google API服务器。

优点:

- 免费额度足够个人开发者使用

- 相较VPN更加稳定和快速,平均延迟700-1200ms

- 不易被监测和封禁

缺点:

- 需要一定的技术基础

- 配置过程相对复杂

- 存在每日请求次数限制

- 缺乏技术支持,问题需自行解决

- 总成本包括域名、服务器和API费用

如果您有技术基础并想尝试这种方法,可以部署以下代码到Cloudflare Workers:

export default {

async fetch(request, env) {

const url = new URL(request.url);

url.host = 'generativelanguage.googleapis.com';

// 复制原始请求

const newRequest = new Request(url, request);

// 发送请求到Google API

return fetch(newRequest);

}

}虽然这种方法适合技术爱好者,但它依然存在不少局限性,尤其是在企业级应用场景中可能面临稳定性和可靠性挑战。

方案三:使用API中转服务(推荐方案)

对于追求稳定性、便捷性和成本效益的用户,专业的API中转服务是最佳选择。LaoZhang.ai提供了全面且稳定的中转API服务,专为国内用户访问Gemini等大模型优化。

优点:

- 超稳定的直连体验,平均响应时间400-600ms

- 使用成本低于原生API 20-30%

- 专业的7×24小时技术支持

- 标准化API接口,兼容OpenAI格式

- 注册即送免费体验额度

- 支持Gemini、Claude、GPT等多种模型一站式接入

- 全球分布式节点,99.9%服务可用性

- 无需任何维护工作

缺点:

- 需要创建账号并获取API密钥

- 大规模调用需要付费(但仍比原生API更便宜)

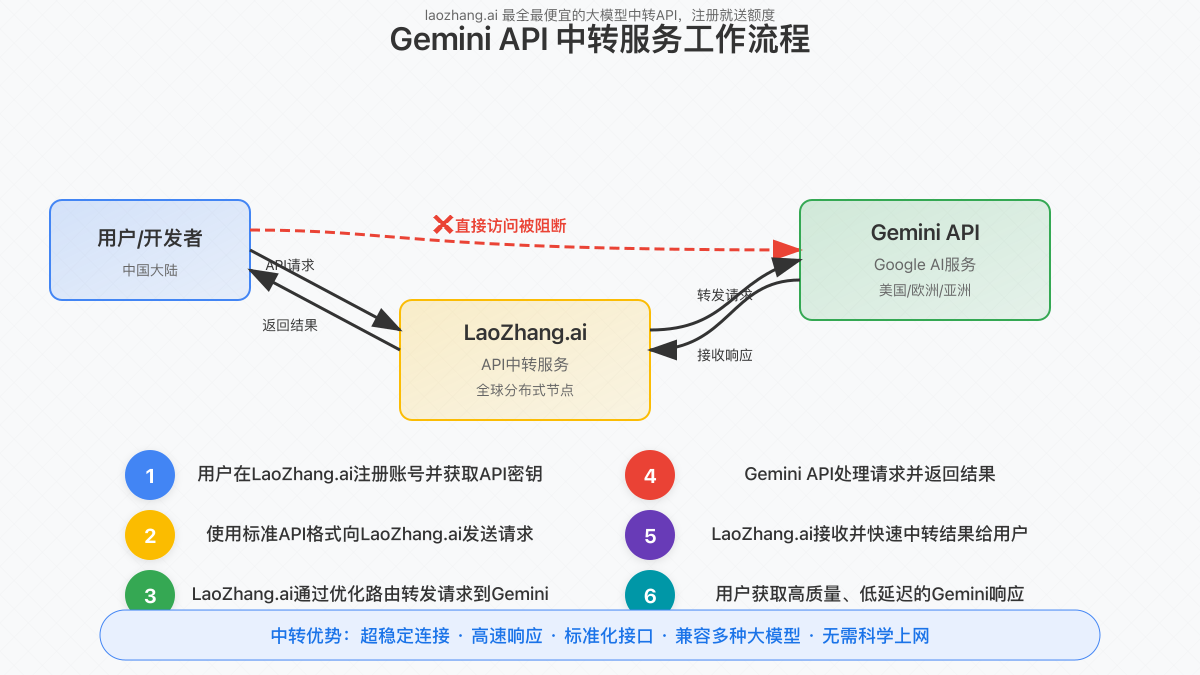

LaoZhang.ai API中转服务的工作原理

LaoZhang.ai通过精心设计的全球分布式网络架构,解决了中国用户访问Gemini API的各种障碍:

- 用户在LaoZhang.ai注册账号并获取API密钥

- 使用标准OpenAI兼容格式向LaoZhang.ai发送请求

- LaoZhang.ai通过优化路由转发请求到Gemini

- Gemini API处理请求并返回结果

- LaoZhang.ai接收并快速中转结果给用户

- 用户获取高质量、低延迟的Gemini响应

这种方案不仅解决了区域限制问题,还通过多路径智能调度和全球节点优化,提供了比直接访问更稳定、更快速的服务体验。

【实战教程】使用LaoZhang.ai稳定访问Gemini完整指南

步骤1:注册并获取API密钥

- 访问LaoZhang.ai官网注册账号

- 完成邮箱验证并登录

- 在控制台页面找到”API密钥”选项

- 点击”创建新密钥”按钮

- 为API密钥设置名称(如”Gemini访问”)并创建

- 复制并安全保存生成的API密钥

💡 专业提示:API密钥只显示一次,请务必妥善保存。建议创建多个密钥用于不同项目,以便更好地管理和追踪使用情况。

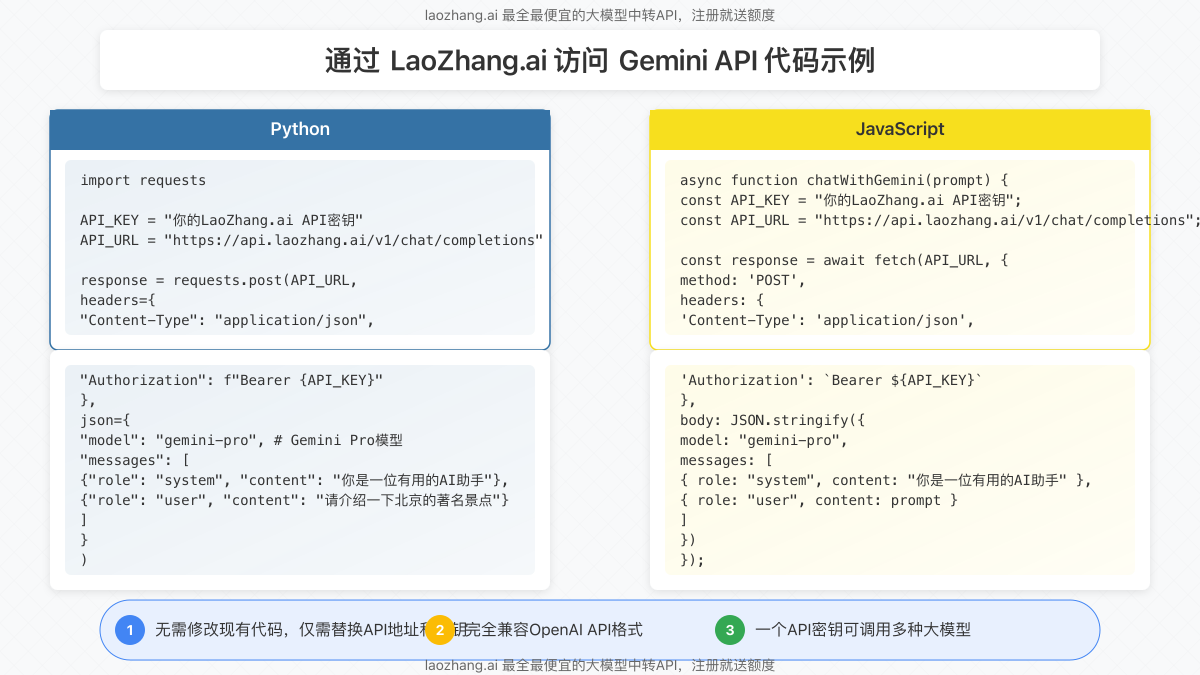

步骤2:通过API调用Gemini

LaoZhang.ai的接口与OpenAI完全兼容,只需在model参数中指定Gemini模型即可。以下是几种常用编程语言的示例:

Python示例

import requests

API_KEY = "你的LaoZhang.ai API密钥"

API_URL = "https://api.laozhang.ai/v1/chat/completions"

def chat_with_gemini(prompt):

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

data = {

"model": "gemini-pro", # 使用Gemini Pro模型

"messages": [

{"role": "system", "content": "你是一位有用的AI助手。"},

{"role": "user", "content": prompt}

]

}

response = requests.post(API_URL, headers=headers, json=data)

return response.json()

# 测试调用

result = chat_with_gemini("你好,请介绍一下北京的著名景点。")

print(result["choices"][0]["message"]["content"])JavaScript/Node.js示例

async function chatWithGemini(prompt) {

const API_KEY = "你的LaoZhang.ai API密钥";

const API_URL = "https://api.laozhang.ai/v1/chat/completions";

const response = await fetch(API_URL, {

method: 'POST',

headers: {

'Content-Type': 'application/json',

'Authorization': `Bearer ${API_KEY}`

},

body: JSON.stringify({

model: "gemini-pro",

messages: [

{ role: "system", content: "你是一位有用的AI助手。" },

{ role: "user", content: prompt }

]

})

});

const data = await response.json();

return data.choices[0].message.content;

}

// 测试调用

chatWithGemini("请用中文解释量子计算的基本原理")

.then(response => console.log(response));cURL命令行示例

curl https://api.laozhang.ai/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer 你的LaoZhang.ai API密钥" \

-d '{

"model": "gemini-pro",

"messages": [

{"role": "system", "content": "你是一位有用的AI助手。"},

{"role": "user", "content": "请解释一下什么是量子纠缠。"}

]

}'步骤3:使用其他Gemini系列模型

LaoZhang.ai支持Gemini系列的所有主要模型,只需在API调用中修改model参数即可:

gemini-pro:文本生成主力模型gemini-pro-vision:支持图像理解的多模态模型gemini-flash:快速响应轻量级模型gemini-1.5-pro:最新的高级版本gemini-1.5-flash:最新的快速版本

例如,要使用支持图像的Gemini Pro Vision模型,只需修改代码中的model参数并添加图像URL:

data = {

"model": "gemini-pro-vision",

"messages": [

{"role": "system", "content": "你是一位有用的AI助手。"},

{"role": "user", "content": [

{"type": "text", "text": "这张图片中有什么?"},

{"type": "image_url", "image_url": {"url": "https://example.com/image.jpg"}}

]}

]

}【高级技巧】提升Gemini使用体验的5个专业建议

1. 批量请求优化

对于需要频繁调用API的场景,采用批量请求可以大幅提高效率并节省成本:

def batch_requests(prompts, batch_size=5):

results = []

for i in range(0, len(prompts), batch_size):

batch = prompts[i:i+batch_size]

# 使用异步并行请求处理一批提示

batch_results = async_process(batch)

results.extend(batch_results)

return results2. 错误处理与重试机制

添加智能重试机制可以有效应对网络波动:

def request_with_retry(prompt, max_retries=3):

for attempt in range(max_retries):

try:

return chat_with_gemini(prompt)

except Exception as e:

if attempt < max_retries - 1:

# 指数退避策略

sleep_time = 2 ** attempt

print(f"请求失败,{sleep_time}秒后重试: {e}")

time.sleep(sleep_time)

else:

raise3. 流式响应处理

对于长文本生成,使用流式响应API可以提供更好的用户体验:

def stream_chat(prompt):

headers = {

"Content-Type": "application/json",

"Authorization": f"Bearer {API_KEY}"

}

data = {

"model": "gemini-pro",

"messages": [

{"role": "system", "content": "你是一位有用的AI助手。"},

{"role": "user", "content": prompt}

],

"stream": True

}

response = requests.post(API_URL, headers=headers, json=data, stream=True)

for line in response.iter_lines():

if line:

# 处理流式数据

yield process_stream_chunk(line)4. 系统提示工程

精心设计的系统提示可以显著提升Gemini的输出质量:

system_prompt = """你是一位专业的中文写作助手,专长于:

1. 使用准确、地道的中文表达

2. 提供结构清晰、逻辑严密的内容

3. 根据内容自动调整语气和风格

4. 确保内容深度和广度的平衡

请始终遵循以下原则:

- 优先使用中国大陆的用语习惯

- 避免使用网络流行语和过于口语化的表达

- 保持客观专业,除非特别要求

"""5. 模型切换策略

根据不同任务特点动态选择最适合的模型:

def choose_best_model(task_type, content_length, response_time_requirement):

if task_type == "image_analysis":

return "gemini-pro-vision"

elif response_time_requirement == "fast":

return "gemini-flash"

elif content_length > 5000:

return "gemini-1.5-pro"

else:

return "gemini-pro"常见问题解答(FAQ)

为什么我应该选择LaoZhang.ai而不是VPN或自建代理?

回答:LaoZhang.ai提供了三大核心优势:

- 稳定性:专业团队维护的服务架构,连接成功率达99.9%

- 性价比:比VPN服务更便宜,无需支付服务器和维护成本

- 便捷性:零配置即可使用,同时支持多种大模型

LaoZhang.ai的API和官方Gemini API有什么区别?

回答:从功能和接口规范角度,LaoZhang.ai与官方API完全一致,区别在于:

- LaoZhang.ai在中国大陆可以直接访问,无需任何代理

- 接口格式遵循OpenAI标准,更容易集成和使用

- 提供额外的错误处理和稳定性保障

- 支持更多种类的大模型,一个接口调用多种AI

免费额度够用多久?具体价格如何计算?

回答:注册即赠送10元体验金,根据正常使用频率可使用约1-2周。正式使用时,LaoZhang.ai采用按使用量计费模式,Gemini模型价格低至0.002元/1K tokens,比原生API更便宜约20-30%。详细定价可访问价格页面查看。

数据安全如何保障?会存储我的请求内容吗?

回答:LaoZhang.ai仅作为技术中转,默认不存储任何用户请求内容和返回结果。所有数据传输采用企业级加密方案,确保端到端安全。平台符合主流数据合规要求,可安心用于商业项目。

支持哪些编程语言和框架调用?

回答:由于采用标准的RESTful API接口,LaoZhang.ai支持几乎所有主流编程语言,包括但不限于Python、JavaScript、Java、Go、PHP、Ruby、C#等。同时兼容各类主流AI开发框架,如LangChain、LlamaIndex等。

遇到技术问题如何获取支持?

回答:LaoZhang.ai提供多种技术支持渠道:

- 官方文档中心:详细的API文档和示例代码

- 在线客服:工作时间内提供实时技术咨询

- 邮件支持:24小时响应技术问题

- 添加微信:ghj930213,获取一对一技术支持

总结:国内稳定访问Gemini API的最佳实践

通过本文的详细分析和对比,我们可以清晰地看到,对于中国大陆用户而言,使用专业的API中转服务是访问Gemini最稳定、最经济的解决方案。LaoZhang.ai凭借其卓越的稳定性、兼容性和性价比,成为国内开发者和企业用户的首选。

无论你是进行个人AI实验、开发创新应用,还是部署企业级AI解决方案,LaoZhang.ai都能满足你对Gemini稳定访问的需求。通过简单的API调用,即可畅享Google最先进的AI大模型能力,而无需担心地域限制和连接问题。

🚀 立即行动:访问LaoZhang.ai注册账号,获取免费额度,开启您的Gemini AI之旅!

🔄 2025年5月更新:LaoZhang.ai现已支持最新的Gemini 1.5 Pro和Gemini 1.5 Flash模型,为国内用户带来第一时间体验最新AI技术的机会!