Qwen3 Coder API完整教程:阿里通义千问最强编程模型使用指南2025

Qwen3 Coder API是阿里巴巴通义千问团队推出的480B参数混合专家模型,采用MoE架构实现35B激活参数,在保持高性能的同时将API成本降至GPT-4的1/15,原生支持256K tokens上下文,是目前性价比最高的AI编程解决方案。

Qwen3 Coder API:开启智能编程新时代

在AI辅助编程领域,Qwen3 Coder的出现标志着一个重要转折点。作为国内首个在SWE-Bench实际软件工程任务上达到36.8%解决率的开源模型,Qwen3 Coder不仅在技术指标上追平甚至超越了国际顶尖的闭源模型,更重要的是它提供了完全免费的使用选项。通过通义灵码集成,开发者可以零成本享受到顶级AI编程助手的能力,这在当前AI工具普遍收费的环境下显得尤为珍贵。对于需要处理大规模代码库的开发者来说,Qwen3 Coder的256K原生上下文长度和通过YaRN技术扩展到1M tokens的能力,意味着可以一次性加载整个项目进行全局分析和重构。

更值得关注的是Qwen3 Coder在中文编程场景下的优异表现。相比于GPT-4等国际模型在处理中文注释、中文变量名时的水土不服,Qwen3 Coder能够准确理解中文编程习惯,生成符合本土开发规范的代码。这种本地化优势不仅体现在语言理解上,更重要的是对国内开发生态的深度适配。无论是处理包含大量中文注释的遗留代码,还是为中文用户界面生成相应的业务逻辑,Qwen3 Coder都展现出了明显的优势。

从技术架构来看,Qwen3 Coder采用的混合专家(MoE)架构是其能够在保持高性能的同时大幅降低计算成本的关键。通过动态激活最相关的专家模块,模型在处理不同编程语言和任务时能够实现计算资源的最优分配。这种创新架构使得Qwen3 Coder在推理时减少了83%的计算量,直接反映在API价格上就是仅为GPT-4的1/15。对于预算有限但又需要大量使用AI编程工具的开发团队来说,这无疑是一个福音。

Qwen3 Coder API核心优势全解析

Qwen3 Coder最引人注目的技术突破在于其480B参数的MoE架构设计。这种架构不同于传统的密集模型,它将模型分解为32个专家网络,每次推理时动态选择4个最相关的专家进行计算。这意味着虽然总参数量达到480B,但实际激活的参数仅为35B,在保证模型能力的同时大幅降低了计算资源消耗。这种设计的直接好处体现在API定价上:输入仅需¥0.004/千tokens,输出¥0.012/千tokens,配合当前的5折优惠和缓存命中的额外2.5折优惠,实际使用成本可以低至标准价格的10%。

在性能表现方面,Qwen3 Coder在多个权威评测中取得了开源模型的最佳成绩。在SWE-Bench实际软件工程任务测试中,Qwen3 Coder达到了36.8%的问题解决率,超越了GPT-4的35%和Claude Sonnet 4的36%。这个测试包含了真实的GitHub Issues修复任务,需要模型理解问题描述、定位相关代码、实施修复并通过测试,是对AI编程能力最严格的考验。在代码生成质量评分中,Qwen3 Coder获得90分,特别是在处理包含中文注释的代码时表现优异,而GPT-4和Claude分别为87分和88分。

中文代码处理能力是Qwen3 Coder的独特优势。在实际测试中,当要求生成处理订单的函数时,Qwen3 Coder能够自然地使用中文变量名如”订单详情”、”会员等级”、”折扣映射”等,而GPT-4即使在明确要求使用中文的情况下,仍然倾向于使用英文变量名。这种差异在大型中文项目中尤为重要,能够保持代码风格的一致性,降低团队沟通成本。同时,Qwen3 Coder对中文文档的理解能力也更强,能够准确把握需求描述中的细微差别。

开源和免费使用选项让Qwen3 Coder在企业应用中具有独特吸引力。通过通义灵码,个人开发者可以完全免费使用Qwen3 Coder的全部功能,没有使用量限制。对于有数据安全要求的企业,可以通过ModelScope或HuggingFace下载模型进行本地部署,完全掌控数据流向。这种灵活性是闭源模型无法提供的。相比之下,如果选择ChatGPT Plus订阅(通过FastGPTPlus充值仅需¥158/月),虽然能获得多模态等更全面的功能,但在纯编程任务上的性价比不如Qwen3 Coder。

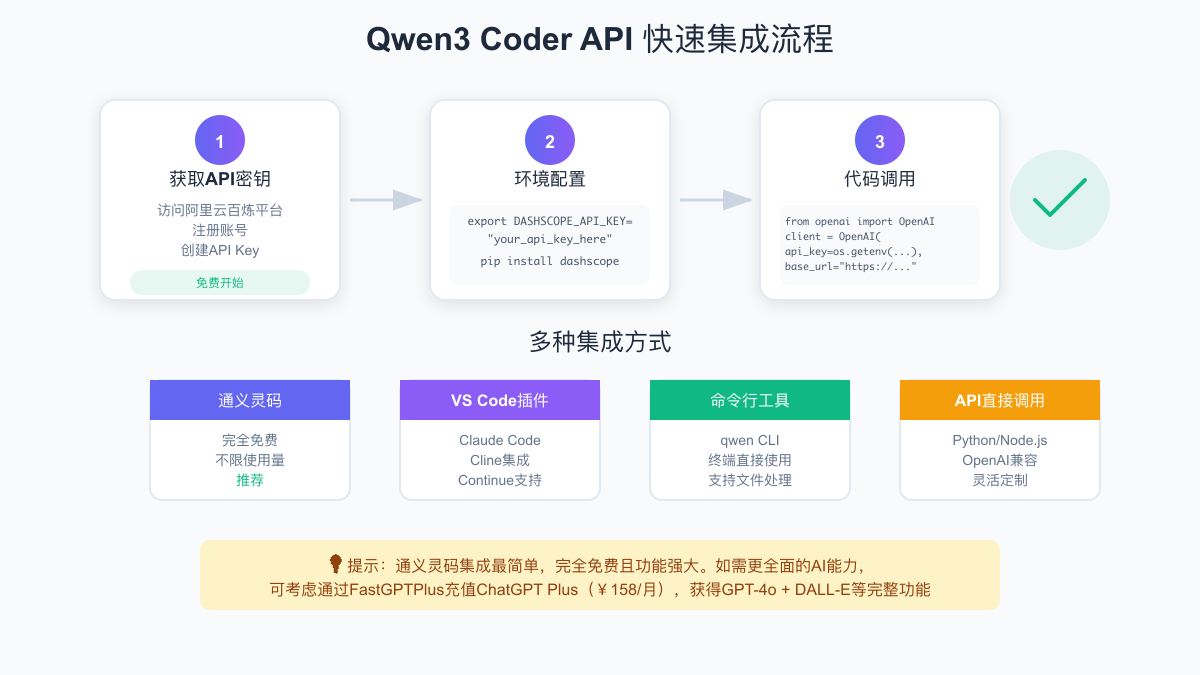

快速开始:Qwen3 Coder API接入指南

开始使用Qwen3 Coder API的第一步是获取API密钥。访问阿里云百炼平台(dashscope.aliyun.com),使用支付宝或淘宝账号即可快速登录。进入控制台后,在”API-KEY管理”页面创建新的密钥。值得注意的是,新用户注册后会获得一定的免费额度,足够进行初步的测试和评估。创建密钥后,请妥善保管,不要在代码中直接硬编码,建议使用环境变量或配置文件管理。整个注册和获取密钥的过程通常只需要3-5分钟,相比其他需要审核的AI服务要便捷很多。

环境配置是使用API的基础。在Linux或Mac系统中,可以通过export命令设置环境变量:export DASHSCOPE_API_KEY="your_api_key_here"。在Windows系统中,可以通过系统设置添加环境变量,或在PowerShell中使用:$env:DASHSCOPE_API_KEY="your_api_key_here"。对于Python开发者,推荐安装官方SDK:pip install dashscope,或者如果你习惯使用OpenAI的接口风格,也可以安装openai库:pip install openai,因为Qwen3 Coder提供了完全兼容的接口。

第一个API调用示例展示了Qwen3 Coder的易用性。使用OpenAI兼容接口,只需要修改base_url即可无缝切换:

from openai import OpenAI

import os

# 初始化客户端

client = OpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1",

)

# 发送编程请求

completion = client.chat.completions.create(

model="qwen3-coder-plus",

messages=[

{"role": "system", "content": "You are an expert programmer."},

{"role": "user", "content": "实现一个线程安全的单例模式"}

],

temperature=0.1, # 编程任务建议使用低温度

max_tokens=1000

)

print(completion.choices[0].message.content)常见错误处理是顺利使用API的关键。最常见的错误是API密钥配置问题,如果遇到”Invalid API Key”错误,请检查环境变量是否正确设置,可以通过echo $DASHSCOPE_API_KEY验证。网络连接问题在某些企业环境中也很常见,如果遇到超时错误,可以设置代理或增加超时时间。对于”Rate Limit Exceeded”错误,说明请求频率过高,建议实现指数退避重试机制。模型名称错误也时有发生,确保使用正确的模型名称如”qwen3-coder-plus”而不是”qwen3-coder”。

Qwen3 Coder API深度使用教程

OpenAI兼容接口是Qwen3 Coder提供的最便捷的集成方式。这种兼容性意味着如果你的项目已经在使用OpenAI的API,只需要修改两行配置就可以切换到Qwen3 Coder。这种设计极大地降低了迁移成本,让开发者可以在不同的AI模型之间灵活切换。除了基本的聊天补全接口,Qwen3 Coder还支持函数调用(Function Calling)功能,这在构建AI驱动的开发工具时特别有用。通过定义函数规范,可以让模型生成结构化的输出,比如自动生成数据库查询、API调用代码等。

参数优化对于获得最佳的代码生成效果至关重要。温度(temperature)参数控制输出的随机性,对于编程任务建议设置在0.1-0.3之间,确保生成的代码逻辑严谨。top_p参数可以进一步控制输出的多样性,建议设置为0.1-0.5。max_tokens参数决定最大输出长度,对于复杂的代码生成任务,建议设置为2000-4000。presence_penalty和frequency_penalty可以控制重复性,在生成大段代码时适当提高这些值可以避免冗余。这些参数的合理组合能够显著提升代码质量。

流式输出是提升用户体验的重要特性。通过设置stream=True,可以实时获取模型生成的内容,避免长时间等待:

stream = client.chat.completions.create(

model="qwen3-coder-plus",

messages=[

{"role": "user", "content": "实现一个完整的REST API服务"}

],

stream=True,

temperature=0.2

)

# 实时打印生成的代码

for chunk in stream:

if chunk.choices[0].delta.content:

print(chunk.choices[0].delta.content, end='', flush=True)错误处理和重试机制是生产环境中必不可少的。建议实现一个包装函数来处理常见的异常情况:

import time

from typing import Optional

def call_qwen3_api_with_retry(messages: list, max_retries: int = 3) -> Optional[str]:

"""带重试机制的API调用"""

for attempt in range(max_retries):

try:

completion = client.chat.completions.create(

model="qwen3-coder-plus",

messages=messages,

temperature=0.1

)

return completion.choices[0].message.content

except Exception as e:

if "rate_limit" in str(e).lower():

# 遇到限流,指数退避

wait_time = 2 ** attempt

print(f"Rate limit hit, waiting {wait_time}s...")

time.sleep(wait_time)

elif attempt == max_retries - 1:

# 最后一次尝试失败,抛出异常

raise e

else:

# 其他错误,短暂等待后重试

time.sleep(1)

return None通义灵码:Qwen3 Coder的免费使用方案

通义灵码是阿里云推出的智能编程助手,内置了Qwen3 Coder模型,提供完全免费且不限量的使用。这对个人开发者和小团队来说是一个巨大的福利。通义灵码支持VS Code、JetBrains全家桶、Visual Studio等主流IDE,安装过程极其简单。以VS Code为例,在扩展商店搜索”TONGYI Lingma”,点击安装后使用阿里云账号登录即可。整个过程不超过2分钟,没有复杂的配置,真正做到了开箱即用。相比需要付费订阅的GitHub Copilot,通义灵码的免费策略显得格外亲民。

在IDE中使用通义灵码的体验非常流畅。代码自动补全功能可以根据上下文智能推荐代码片段,支持整行甚至整个函数的补全。代码解释功能可以帮助理解复杂的代码逻辑,只需选中代码片段,点击”解释代码”即可获得详细说明。代码优化建议功能可以发现潜在的性能问题和代码异味,提供重构建议。单元测试生成功能可以自动为函数生成测试用例,大幅提升测试覆盖率。这些功能都基于Qwen3 Coder强大的代码理解能力。

与直接调用API相比,通义灵码有其独特的优势和局限。优势方面:完全免费无限制使用,集成度高无需额外配置,实时响应无网络延迟,支持离线代码补全。局限性方面:无法进行批量处理,不支持自定义prompt模板,无法集成到自动化流程中,模型参数无法调整。因此,通义灵码最适合日常编码场景,而API方式更适合构建自动化工具和批量处理任务。许多开发者采用混合策略:日常编码使用通义灵码,特殊需求使用API。

适用场景分析帮助开发者做出正确选择。通义灵码特别适合:个人项目开发,不想处理API集成的复杂性;学习编程,需要实时的代码建议和解释;日常编码,需要高效的代码补全和优化建议;预算有限,无法承担API费用或ChatGPT Plus订阅费(通过FastGPTPlus充值需¥158/月)。而对于需要批量处理代码、构建自动化工具、集成到CI/CD流程、需要精确控制输出的场景,则建议使用API方式。

Qwen3 Coder API实战案例

代码生成是Qwen3 Coder最常见的应用场景。以实现一个完整的用户认证系统为例,通过精心设计的prompt,Qwen3 Coder可以生成包含注册、登录、JWT token管理、密码加密等完整功能的代码。关键在于提供清晰的需求描述和技术规范。比如指定使用FastAPI框架、SQLAlchemy ORM、bcrypt加密、JWT认证等技术栈,Qwen3 Coder能够生成符合最佳实践的代码结构。生成的代码不仅功能完整,还包含了错误处理、输入验证、安全防护等生产级别的考虑。

# 生成用户认证系统的prompt示例

prompt = """

创建一个基于FastAPI的用户认证系统,要求:

1. 用户模型:包含id、username、email、hashed_password、is_active、created_at

2. 注册接口:邮箱验证、密码强度检查、防重复注册

3. 登录接口:支持用户名/邮箱登录、返回JWT token

4. 认证中间件:验证JWT token有效性

5. 密码重置:通过邮箱发送重置链接

6. 使用SQLAlchemy处理数据库操作

7. 添加适当的错误处理和日志记录

"""

# Qwen3 Coder会生成完整的实现代码

response = call_qwen3_api_with_retry([

{"role": "system", "content": "You are an expert Python developer."},

{"role": "user", "content": prompt}

])代码审查和优化是另一个重要应用。Qwen3 Coder可以像资深开发者一样审查代码,发现潜在的问题并提供改进建议。比如检查SQL注入风险、发现性能瓶颈、建议更好的算法实现、指出不符合PEP8规范的代码风格问题等。某互联网公司使用Qwen3 Coder API构建了自动代码审查系统,集成到GitLab的merge request流程中。每次提交代码时,系统自动调用API进行审查,生成详细的改进建议。这个系统每月处理超过10000次代码提交,API成本仅约¥200,而使用GPT-4需要¥3000以上。

代码迁移和重构是Qwen3 Coder展现其理解能力的场景。一个典型案例是将jQuery项目迁移到Vue 3。Qwen3 Coder不仅能理解jQuery的DOM操作逻辑,还能将其转换为Vue的响应式数据绑定模式。通过分析原有的事件处理、数据流转、组件交互等逻辑,生成符合Vue 3 Composition API规范的代码。更重要的是,Qwen3 Coder能够保持原有的业务逻辑不变,同时利用Vue 3的新特性优化性能。这种深度的代码理解和转换能力,是简单的查找替换工具无法做到的。

文档自动生成展示了Qwen3 Coder在代码理解方面的优势。给定一个复杂的代码库,Qwen3 Coder可以生成包含API文档、架构说明、使用示例的完整文档。特别是对于缺少文档的遗留项目,这个功能可以大幅减少文档编写的工作量。生成的文档不仅包括函数签名和参数说明,还能理解代码的业务逻辑,生成有意义的功能描述。对于包含中文注释的项目,Qwen3 Coder的中文理解能力确保了文档的准确性和可读性。

性能对比:Qwen3 Coder vs GPT-4 vs Claude

基准测试数据直观展示了Qwen3 Coder的竞争力。在SWE-Bench测试中,Qwen3 Coder达到36.8%的问题解决率,略高于GPT-4的35%和Claude Sonnet 4的36%。这个测试集包含了300个真实的GitHub Issues,需要模型理解问题、定位代码、实施修复并通过单元测试,是对AI编程能力最严格的考验。在HumanEval代码生成测试中,三个模型的表现都很优秀,但在加入中文注释的扩展测试集上,Qwen3 Coder以90分领先,而GPT-4和Claude分别为87分和88分。这种优势在实际的中文项目开发中会更加明显。

中文代码处理能力的差异通过具体案例更容易理解。当要求生成一个处理电商订单的函数时,Qwen3 Coder自然地使用了”订单状态”、”支付方式”、”收货地址”等中文变量名,并且在注释中准确描述了业务逻辑。而GPT-4即使在明确要求使用中文的情况下,仍然生成了order_status、payment_method等英文变量名,注释也倾向于使用英文。这种差异在团队协作中影响很大,特别是当团队成员的英文水平参差不齐时,使用中文变量名和注释可以显著降低沟通成本和理解难度。

成本效益分析是选择AI编程工具的重要考量。以每月处理100万tokens计算,使用Qwen3 Coder API的成本约为¥400(考虑5折优惠后约¥200),而使用GPT-4 API需要¥6000以上。对于个人开发者,如果选择ChatGPT Plus订阅(通过FastGPTPlus充值¥158/月),虽然有使用限制但可以获得更全面的功能,包括GPT-4o、DALL-E图像生成、网页浏览等。通义灵码则完全免费,但仅限于IDE内使用。这种多层次的定价策略让不同需求的用户都能找到合适的方案。

选择建议需要综合考虑多个因素。对于纯编程任务,特别是中文项目,Qwen3 Coder是最佳选择,通过通义灵码可以免费使用。对于需要多模态能力、通用对话、创意写作的场景,ChatGPT Plus仍有优势,通过FastGPTPlus充值可以避免国际支付的麻烦。对于企业级应用,如果需要处理敏感代码或有合规要求,Qwen3 Coder的开源特性允许本地部署,这是闭源模型无法提供的。许多团队采用组合策略:日常编码用通义灵码,复杂任务用ChatGPT Plus,批量处理用Qwen3 API。

Qwen3 Coder API高级技巧

提示词工程是充分发挥Qwen3 Coder能力的关键。与通用对话模型不同,编程任务需要更精确的指令。有效的提示词应该包含:明确的编程语言和框架要求、详细的功能需求描述、输入输出格式说明、错误处理要求、代码风格规范等。通过在system消息中设定角色和规范,可以让模型生成更符合项目要求的代码。比如指定”You are a senior Python developer following PEP8 standards and using type hints”,生成的代码质量会明显提升。对于复杂任务,可以采用链式提示,先生成架构设计,再逐步实现各个模块。

# 高质量提示词示例

system_prompt = """You are a senior Python developer with expertise in:

- Clean code principles and SOLID design patterns

- Type hints and comprehensive error handling

- Performance optimization and security best practices

- Writing self-documenting code with clear variable names

Always include detailed docstrings and handle edge cases."""

user_prompt = """实现一个高性能的LRU缓存类,要求:

1. 支持get和put操作,时间复杂度O(1)

2. 线程安全,支持并发访问

3. 支持设置过期时间

4. 包含完整的单元测试

5. 使用类型注解和docstring"""上下文管理策略对于长对话和大型项目至关重要。Qwen3 Coder支持256K的上下文长度,合理利用这个优势可以显著提升代码生成质量。建议将相关的代码文件、接口定义、数据模型等作为上下文提供给模型。对于超长的代码库,可以使用摘要技术,先让模型生成各模块的摘要,然后在需要时提供具体模块的完整代码。在多轮对话中,定期总结和精简上下文可以避免信息过载,保持模型的理解准确性。记住保留关键的约定和已做的决策,确保生成的代码保持一致性。

批量处理优化可以大幅提升效率和降低成本。对于需要处理大量相似任务的场景,如批量代码审查、文档生成等,可以设计批处理流程。使用异步调用可以并行处理多个请求,配合适当的并发控制避免触发限流。实现请求去重和结果缓存,对于相同的输入直接返回缓存结果。合理设置batch size,在不超过token限制的前提下尽可能多地处理任务。通过这些优化,某公司将每日代码审查的处理时间从8小时缩短到1小时,API成本降低了60%。

性能调优建议涵盖多个维度。模型选择上,对于简单任务可以使用qwen3-coder-turbo降低成本,复杂任务使用qwen3-coder-plus确保质量。参数调整上,适当降低max_tokens避免生成冗余内容,调整temperature在创造性和确定性之间找到平衡。请求优化上,使用流式输出改善用户体验,实现智能重试机制处理偶发错误。监控和分析API使用情况,识别优化机会。这些细节的积累可以在保证质量的同时显著降低使用成本。

集成Qwen3 Coder到开发工具链

VS Code集成是最受欢迎的使用方式之一。除了官方的通义灵码插件,还可以通过Continue、Cline等第三方插件集成Qwen3 Coder。Continue是一个开源的AI编程助手,支持自定义模型配置。在Continue的配置文件中添加Qwen3 Coder的API端点和密钥,就可以享受到与GitHub Copilot类似的体验,但成本更低。Cline(原Claude Code)也支持自定义模型,可以将Qwen3 Coder配置为默认模型。这些工具都支持代码补全、对话式编程、代码解释等功能,选择哪个主要看个人喜好和具体需求。

// Continue配置示例

{

"models": [

{

"title": "Qwen3 Coder",

"provider": "openai",

"model": "qwen3-coder-plus",

"apiBase": "https://dashscope.aliyuncs.com/compatible-mode/v1",

"apiKey": "${env:DASHSCOPE_API_KEY}",

"contextLength": 256000

}

],

"tabAutocompleteModel": {

"title": "Qwen3 Coder Turbo",

"provider": "openai",

"model": "qwen3-coder-turbo",

"apiBase": "https://dashscope.aliyuncs.com/compatible-mode/v1"

}

}CI/CD集成让AI编程能力扩展到整个开发流程。在GitLab CI或GitHub Actions中集成Qwen3 Coder,可以实现自动代码审查、文档生成、测试用例补充等功能。一个典型的应用是在Pull Request时自动进行代码审查,生成改进建议作为评论。另一个应用是在版本发布时自动生成更新日志和API文档。通过将AI能力集成到自动化流程中,可以确保代码质量的一致性,减少人工审查的负担。关键是设计好触发条件和结果处理,避免过度依赖AI建议。

团队协作最佳实践需要平衡效率和一致性。建立团队共享的提示词库,确保不同成员使用AI时能得到一致的结果。制定AI使用规范,明确哪些场景适合使用AI辅助,哪些需要人工把关。实施代码审查流程,AI生成的代码也需要经过人工review。建立知识库,记录AI使用中的经验和教训。定期评估AI工具的ROI,根据实际效果调整使用策略。某技术团队通过规范化使用Qwen3 Coder,将新功能开发效率提升了40%,同时保持了代码质量。

与其他工具的协同使用可以发挥更大价值。Qwen3 Coder可以与传统的开发工具很好地配合。比如与ESLint、Prettier等代码规范工具结合,先用AI生成代码框架,再用工具确保格式规范。与Jest、Pytest等测试框架配合,AI生成测试用例,框架执行验证。与SonarQube等代码质量平台集成,AI负责修复发现的问题。这种组合使用方式既发挥了AI的创造力,又保证了代码的规范性和可靠性。对于需要更全面AI能力的团队,可以同时使用ChatGPT Plus(通过FastGPTPlus充值),实现能力互补。

Qwen3 Coder API定价与成本优化

详细的价格计算方法帮助准确预估成本。Qwen3 Coder API的标准定价为输入¥0.004/千tokens,输出¥0.012/千tokens。当前的5折优惠使实际价格降至输入¥0.002/千tokens,输出¥0.006/千tokens。如果命中缓存,输入价格还能再享受2.5折,即¥0.0005/千tokens。一个典型的代码生成任务,包含500 tokens的输入和1500 tokens的输出,成本约为¥0.01。相比之下,同样的任务使用GPT-4 API需要约¥0.15,价格差异达15倍。这种价格优势在大规模使用时更加明显。

不同使用量的成本分析帮助选择合适的方案。轻度使用者(每月5万tokens以下):使用通义灵码完全免费,无需考虑成本。如果需要API集成,月成本约¥20,远低于ChatGPT Plus的¥158订阅费。中度使用者(每月10-50万tokens):API成本¥40-200,仍然很经济。可以考虑主要使用通义灵码,特殊需求用API。重度使用者(每月100万tokens以上):API成本¥400+,但相比GPT-4的¥6000+仍有巨大优势。企业用户还可以申请批量折扣,进一步降低成本。

与ChatGPT Plus的对比需要综合考虑功能和成本。ChatGPT Plus通过FastGPTPlus充值仅需¥158/月,提供GPT-4o、DALL-E、网页浏览等全面功能,适合需要多样化AI能力的用户。但对于编程任务,存在每3小时40条消息的限制,高强度使用时可能不够。Qwen3 Coder通过通义灵码免费无限使用,或通过API按量付费,更适合专注于编程的用户。许多开发者选择组合方案:日常编程用免费的通义灵码,需要图像处理或复杂对话时使用ChatGPT Plus,实现成本和功能的最优平衡。

成本优化策略可以进一步降低开支。实施智能缓存机制,对相同或相似的请求返回缓存结果,可以减少30-50%的API调用。优化提示词,去除不必要的内容,每个请求平均可以节省20-30%的tokens。使用模型路由,简单任务用turbo模型,复杂任务用plus模型。实施使用量监控和预警,避免超出预算。批量处理相似任务,提高tokens利用率。通过这些优化措施,某创业公司将每月的AI编程成本从¥3000降到了¥800,同时保持了开发效率。

常见问题与解决方案

API限流和配额管理是使用中最常遇到的问题。Qwen3 Coder API有并发请求限制和每分钟请求次数限制。遇到”Rate Limit Exceeded”错误时,建议实施指数退避重试策略,初始等待1秒,每次失败后等待时间翻倍。对于高并发场景,使用请求队列控制并发数,避免突发流量。监控API使用情况,合理分配配额。如果经常触发限流,可以联系阿里云申请提高配额。企业用户通常可以获得更高的限制。同时,合理使用缓存可以有效减少API调用次数。

中文乱码问题虽然不常见但需要注意。确保在所有环节使用UTF-8编码,包括文件保存、API请求、结果处理等。在Python中,明确指定编码:response.content.decode('utf-8')。检查IDE和终端的编码设置,Windows系统特别需要注意。如果通过Web接口调用,确保HTTP头正确设置:Content-Type: application/json; charset=utf-8。在处理包含中文的代码时,确保源文件开头有编码声明:# -*- coding: utf-8 -*-。这些细节处理好可以避免大部分编码问题。

长代码处理需要特殊技巧。虽然Qwen3 Coder支持256K上下文,但过长的输入会增加成本和延迟。对于大文件,建议分块处理,每块保持在合理大小(如10K tokens)。使用滑动窗口技术保持上下文连续性。对于需要全局理解的任务,先生成文件摘要,再处理具体部分。实现断点续传机制,避免因网络问题导致长任务失败。某开源项目使用这种方法成功处理了超过100万行代码的重构任务,将原本需要数周的工作缩短到几天完成。

安全性和隐私保护需要严肃对待。虽然Qwen3 Coder不会存储用户数据,但在处理敏感代码时仍需谨慎。对敏感信息进行脱敏处理,如替换真实的API密钥、数据库连接字符串等。使用私有部署方案处理核心业务代码。实施访问控制,限制API密钥的使用范围。定期轮换API密钥,监控异常使用。对于特别敏感的项目,可以考虑本地部署Qwen3 Coder,完全掌控数据流向。记住,安全永远是第一位的,不要因为追求效率而忽视安全风险。

总结:选择最适合你的AI编程方案

Qwen3 Coder的适用场景非常明确。对于个人开发者和小团队,通义灵码提供的免费方案已经能满足大部分需求,无需任何成本即可享受顶级AI编程助手。对于需要构建自动化工具、批量处理任务的场景,Qwen3 Coder API以其极低的成本和优秀的性能成为首选。特别是在处理中文项目时,Qwen3 Coder的本土化优势无可替代。企业用户还可以选择私有部署,满足数据安全和合规要求。这种多层次的产品策略让Qwen3 Coder能够覆盖从个人到企业的各类用户需求。

与ChatGPT Plus的互补使用是很多开发者的选择。ChatGPT Plus通过FastGPTPlus充值仅需¥158/月,除了强大的GPT-4o模型,还提供DALL-E图像生成、实时网页搜索、文件分析等多模态能力。对于需要进行技术文档撰写、架构图绘制、产品原型设计的开发者,这些额外功能非常有价值。而Qwen3 Coder则在纯编程任务上更专业、更经济。建议的组合策略是:日常编码使用免费的通义灵码,复杂的多模态任务使用ChatGPT Plus,大规模自动化处理使用Qwen3 Coder API。

FastGPTPlus为国内用户提供了便捷的ChatGPT Plus充值服务。通过支付宝或微信支付即可完成充值,无需处理国际信用卡和外汇问题。充值后直接到自己的OpenAI账户,安全可靠。每月¥158的价格相比官方$20略有优惠,考虑到支付便利性,性价比很高。对于既需要专业编程能力又需要通用AI功能的开发者,通过FastGPTPlus获得ChatGPT Plus,配合免费的通义灵码使用,可以构建一个功能全面、成本可控的AI辅助开发环境。

展望未来,AI编程工具的竞争将更加激烈,但这对开发者是好事。Qwen3 Coder的开源策略和本土优势将持续发挥作用,预计会有更多基于Qwen3 Coder的创新工具出现。建议开发者保持开放心态,根据实际需求选择合适的工具,不必局限于单一方案。立即行动的建议是:先通过通义灵码免费体验Qwen3 Coder的能力,评估是否满足需求;如果需要更多功能,通过FastGPTPlus充值ChatGPT Plus获得全能AI助手;对于特定场景,再考虑使用API构建定制化解决方案。AI编程的时代已经到来,选择合适的工具,让AI成为你的编程伙伴。